Un esfuerzo titánico de representación virtual y etiquetado de objetos ha dado lugar a ScanNet, una base de datos sin precedentes que será empleada para entrenar a los ordenadores para entender la realidad a la que se enfrentan

Para que un robot doméstico sea realmente útil debe ser capaz de distinguir entre una mesita baja y la cuna de un niño. Es una tarea muy fácil para los humanos, pero a la mayoría de los robots actuales les resulta imposible..

Un nuevo y enorme conjunto de datos de imágenes en 3D recopilado por investigadores de la Universidad de Stanford (EEUU), la Universidad de Princeton (EEUU) y la Universidad Técnica de Múnich (Alemania) podría ayudar. El conjunto de datos, conocido como ScanNet, incluye miles de escenas con millones de objetos etiquetados como mesitas bajas, sofás, lámparas y televisores. La visión automática ha mejorado mucho en los últimos cinco años, gracias en parte al lanzamiento de un conjunto de datos mucho más sencillo de imágenes en 2D etiquetadas llamado ImageNet, que en su día fue generado por otro grupo de investigaciones de la Universidad de Stanford. ScanNet ofrecerá aún más datos a la misión.

"La enorme cantidad de datos etiquetados de ImageNet impulsó la revolución de la inteligencia artificial”, afirma el profesor de la Universidad Técnica de Múnich y uno de los investigadores responsables del conjunto de datos, Matthias Neissner. La esperanza es que ScanNet proporcione a las máquinas una comprensión mucho más profunda del mundo físico, y que se transforme en aplicaciones prácticas. El investigador añade: "El escenario más obvio es un robot doméstico. Si tienes un robot, necesita averiguar qué sucede a su alrededor".

Video: Un escáner 3D listo para usar fue empleado para captar cada habitación.

Neissner, que realizó el trabajo mientras ejercía de profesor de la Universidad de Stanford, cree que los investigadores aplicarán el aprendizaje profundo (la misma técnica de aprendizaje automático aplicada a ImageNet) para entrenar a los ordenadores para que entiendan mejor las escenas en 3D (ver Aprendizaje profundo). Creó el conjunto de datos con su alumna Angela Dai, el profesor de la Universidad de Princeton Thomas Funkhouser y varios alumnos más.

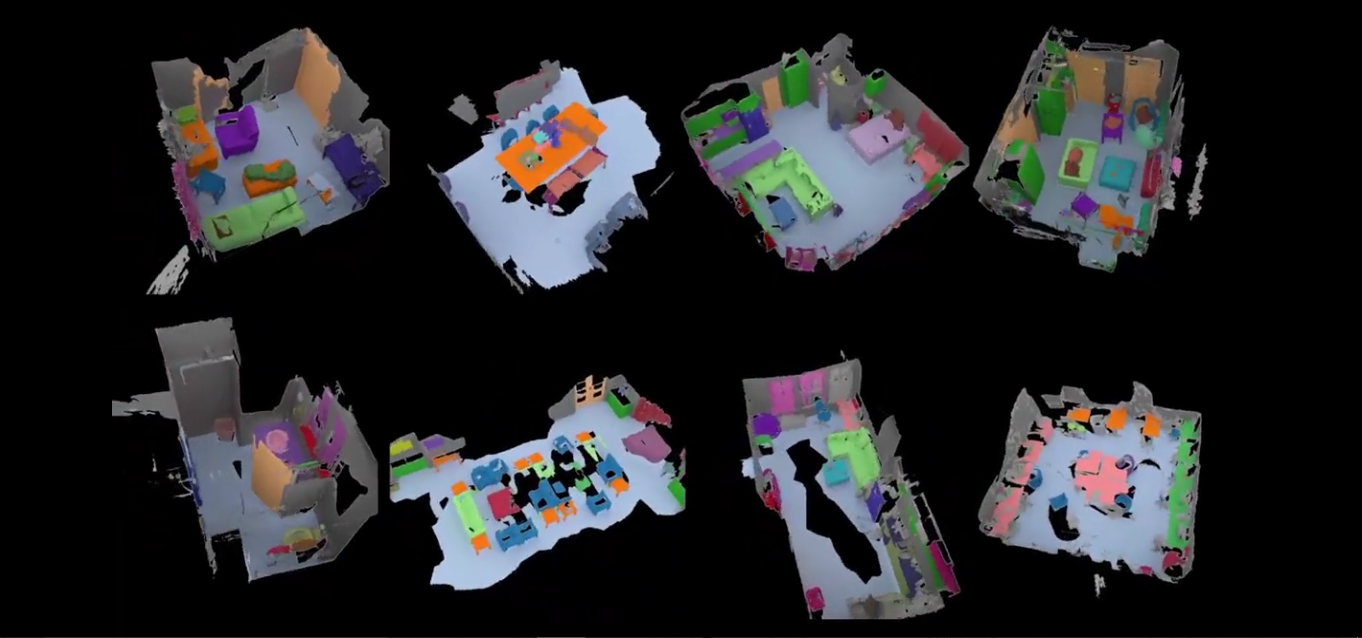

Los investigadores describen su enfoque en un trabajo publicado recientemente. Para elaborar el conjunto de datos, escanearon 1.513 escenas con una cámara 3D similar al Microsoft Kinect. Este dispositivo utiliza tanto una cámara convencional como un sensor de profundidad de infrarrojos para generar una imagen en 3D de la escena. Después, los investigadores consiguieron a voluntarios para etiquetar las imágenes con una app de iPad mediante la plataforma de crowdsourcing Amazon Mechanical Turk. Para mejorar la precisión, un grupo pintó y etiquetó los objetos de una imagen, y el otro recreó la escena con un modelo en 3D.

La profesora de la Universidad de Brown (EEUU) Stefanie Tellex, cuyo trabajo se centra en robots domésticos, afirma que ScanNet es mucho más grande que cualquier cosa anterior. La investigadora detalla: "Hacer un conjunto de datos de ese orden de magnitud es una gran aportación. Las informaciones en 3D son críticas para que los robots puedan percibir e interactuar con su entorno, pero existe una carencia real de datos para tales tarea".

Video: Una habitación que muestra objetos anotados en colores distintos.

Neissner explica que cuando su equipo intentó aplicar el aprendizaje profundo descubrió que era capaz reconocer muchos objetos empleando únicamente sus datos de profundidad o su forma. Esto sugiere que los datos en 3D proporcionarán una comprensión mucho más profunda del mundo físico, asegura. Y añade que utilizar las informaciones en 3D es una manera mejor de imitar cómo los animales reconocen las cosas.

El profesor del Instituto de Robótica de la Universidad de Carnegie Mellon (EEUU) Siddhartha Srinivasa asegura que el nuevo conjunto de datos podría ser un "buen comienzo" para que las máquinas entiendan el interior de los hogares. "La popularidad de ImageNet se debió en parte a la inmensidad del conjunto de datos y sobre todo debido a las numerosas aplicaciones inmediatas del etiquetado de imágenes, especialmente en aplicaciones web", dice Srinivasa. Pero matiza que aunque hay menos aplicaciones obvias para un conjunto de datos en 3D aparte de la robótica y la arquitectura, podrían aparecer otras nuevas muy pronto.

Además, afirma que otros grupos están empleando escenas sintéticas o virtuales para entrenar los sistemas de visión automática. "Aunque simular imágenes de la vida real a menudo no es realista, como se puede ver con las imágenes generadas por ordenador de las películas, la simulación de la profundidad sí es muy realista", concluye.