Las máquinas son hoy día casi tan buenas como los seres humanos y el punto de inflexión en esta mejora tuvo lugar en 2012

En la exploración del espacio, tenemos el Premio Google Lunar X por colocar un vehículo en la superficie lunar. En medicina, está el Premio Qualcomm Tricorder X por el desarrollo de un dispositivo tipo Star Trek para diagnosticar enfermedades. Existe incluso un incipiente Premio X de Inteligencia Artificial por desarrollar un sistema que pueda dar una charla TED interesante.

En el mundo de la visión artificial, el objetivo equivalente es ganar el Reto IMAGEnet de Reconocimieno Visual a Gran Escala. Es una competición que se lleva celebrando cada año desde 2010 para evaluar los algoritmos de reconocimiento de imágenes. (Está diseñada para continuar un proyecto similar llamado PASCAL VOC, que tuvo lugar desde 2005 hasta 2012).

Los concursantes tienen dos tareas sencillas. Se les presenta una imagen de cierto tipo, y la primera tarea es decidir si contiene un determinado tipo de objeto o no. Por ejemplo, un participante podría decidir que en la imagen hay vehículos pero no hay tigres. La segunda tarea es encontrar un objeto en particular y dibujar un cuadro alrededor de él. Por ejemplo, un participante podría decidir que hay un destornillador en una cierta posición con una anchura de 50 píxeles y una altura de 30 píxeles.

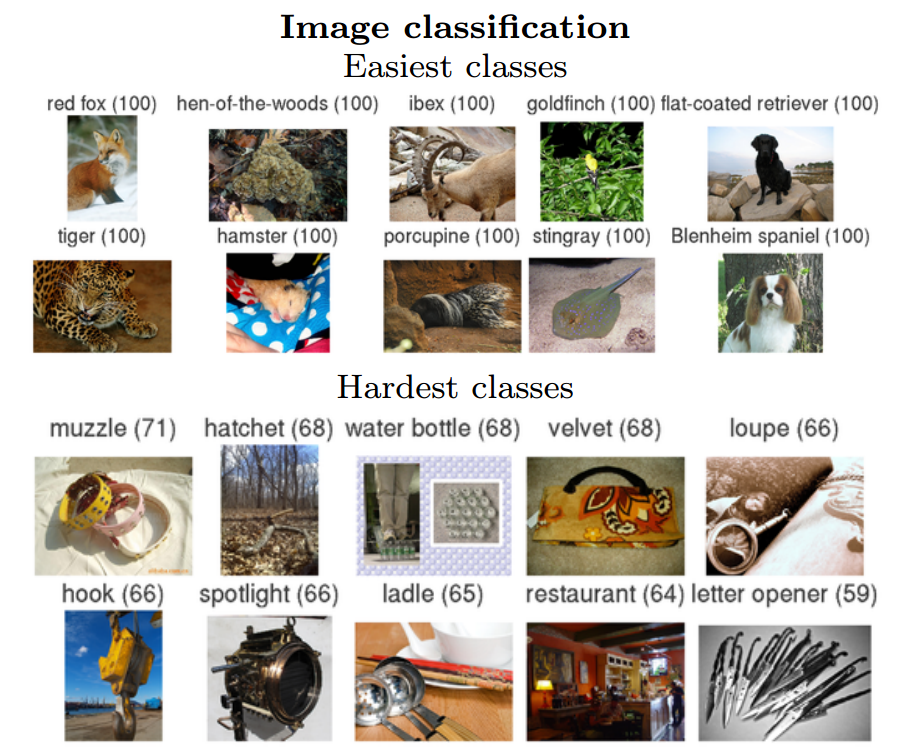

Ah, y una cosa más: hay 1.000 categorías distintas de objetos que van desde un ábaco a un calabacín, y los concursantes tienen que buscar en una base de datos de más de 1 millón de imágenes y encontrar todas las instancias de cada objeto. ¡Nada fácil!

Los ordenadores siempre han tenido problemas para identificar objetos en imágenes reales, así que no es de extrañar que los ganadores de estos concursos siempre hayan tenido un peor rendimiento en comparación con los seres humanos.

Pero todo cambió en 2012 cuando un equipo de la Universidad de Toronto (Canadá) participó con un algoritmo llamado SuperVision, que se llevó por delante a toda la competencia.

Olga Russakovsky desde la Universidad de Stanford en California (EEUU) y varios compañeros han hecho un repaso de toda la historia de esta competición y afirman que, en retrospectiva, la victoria total de SuperVision fue un punto de inflexión para la visión artificial. Aseguran que desde aquel entonces la visión artificial ha mejorado a un ritmo tan rápido que hoy día por primera vez es capaz de competir con los humano en cuanto a exactitud.

¿Qué sucedió en 2012 que cambió el mundo de la visión artificial? La respuesta es una técnica conocida como redes neuronales convolucionales profundas, que el algoritmo de SuperVision utilizó para clasificar los 1,2 millones de imágenes de alta resolución del conjunto de datos en 1.000 clases diferentes.

Esta era la primera vez que una red neuronal convolucional profunda -un tipo de código de detección de errores- había ganado el concurso, y supuso una victoria clara. En 2010, el concursante ganador tuvo una tasa de error del 28,2%, y en 2011 la tasa se redujo al 25,8%. SuperVision ganó con una tasa de sólo el 16,4% en 2012 (el segundo mejor concursante tuvo una tasa de error del 26,2%). Esa clara victoria ha hecho que el método haya sido ampliamente copiado desde entonces.

Las redes neuronales convolucionales constan de varias capas de pequeñas colecciones de neuronas que de forma individual se ocupan de analizar pequeñas partes de una imagen. Los resultados de todas las colecciones de cada capa se superponen para crear una representación de toda la imagen. La capa de abajo repite el proceso en la nueva representación de la imagen, lo que permite al sistema aprender acerca sobre la composición de la imagen.

Las redes neuronales convolucionales profundas se inventaron en la década de 1980. Pero hasta hace sólo dos años los ordenadores no tenían la potencia necesaria para el reconocimiento de imágenes de alta calidad.

Por ejemplo, SuperVision tiene unas 650.000 neuronas dispuestas en cinco capas convolucionales. Tiene alrededor de 60 millones de parámetros que se ajustan durante el proceso de aprendizaje para reconocer objetos en categorías particulares. Esto supone un rango enorme de parámetros que permite el reconocimiento de muchísimos tipos distintos de objetos.

Desde 2012, varios grupos han mejorado de forma significativa el resultado de SuperVision. Este año, un algoritmo llamado GoogLeNet, creado por un equipo de ingenieros de Google, alcanzó una tasa de error de sólo el 6,7%.

Uno de los grandes retos en la organización de este tipo de competiciones es crear un conjunto de datos de alta calidad en primer lugar, según afirman Russakovsky y compañía. Cada imagen en la base de datos tiene que ser categorizada según un patrón oro que los algoritmos deben cumplir. También hay una base de datos de entrenamiento de cerca de 150.000 imágenes que tienen que ser categorizadas.

Esto no resulta fácil dado el gran número de imágenes. Russakovsky y compañía lo han logrado utilizando servicios de crowdsourcing como el Mechanical Turk de Amazon, pidiendo a usuarios humanos que categorizasen las imágenes. Esto requiere una cantidad significativa de planificación, comprobación y repetición cuando no funciona. Pero el resultado es una base de datos de imágenes de alta calidad categorizadas con un alto grado de precisión, señalan.

Una cuestión interesante es saber a qué nivel están los mejores algoritmos en comparación con los seres humanos a la hora de reconocer objetos. Russakovsky y sus colegas han comparado humanos y máquinas y su conclusión parece inevitable. "Nuestros resultados indican que un humano entrenado es capaz de superar al mejor modelo (GoogLeNet) en aproximadamente un 1,7%", afirman.

En otras palabras, no pasará mucho tiempo antes de que las máquinas superen significativamente los seres humanos en las tareas de reconocimiento de imágenes.

Los mejores algoritmos de visión artificial todavía tienen dificultades con objetos pequeños o delgados, como por ejemplo una hormiga pequeña en el tallo de una flor, o una persona con una pluma en la mano. También tienen problemas con imágenes que hayan sido distorsionadas con filtros, un fenómeno cada vez más común en las cámaras digitales modernas.

Por el contrario los humanos no suelen tener problemas con este tipo de imágenes, pero sí con otras. Por ejemplo no se les da bien clasificar objetos en categorías detalladas, como especies específicas de perros o pájaros, mientras que los algoritmos de visión artificial lo hacen con facilidad.

Pero la tendencia está clara. "Está claro que pronto los humanos tendrán que poner esfuerzo, experiencia y tiempo significativo para poder superar a los modelos más avanzados de clasificación de imágenes", aseguran Russakovsky y compañía.

O dicho de otro modo, es sólo cuestión de tiempo antes de tu teléfono inteligente reconozca mejor que tú el contenido de tus propias imágenes.

Ref: http://arxiv.org/abs/1409.0575: ImageNet Large Scale Visual Recognition Challenge