El S1 ha sido programado para errar en sus cálculos. Puede ser tremendamente útil para tareas computacionales complejas, pues las acelera hasta 100 veces y reduce un 98% su consumo energético

Nuestros profesores de matemáticas nos han mentido. A veces equivocarse en las sumas es bueno. Eso afirma el cofundador y CEO de Singular Computing, Joseph Bates. Su empresa desarrolla chips informáticos programados para ser incapaces de realizar correctamente los cálculos matemáticos. Al pedirle que sume 1 + 1 ofrecen respuestas como 2,01 o 1,98.

La agencia de investigación del Pentágono, DARPA, financió el desarrolló del chip de Singular Computing porque esa imprecisión puede representar una ventaja para algunos de los problemas más difíciles para los ordenadores, como entender un vídeo u otros datos engorrosos del mundo real. "Sólo porque el hardware sea inferior no significa que el resultado del software también lo sea", dice Bates.

Un chip que garantiza cálculos imprecisos puede conseguir buenos resultados en muchos problemas, pero necesita menos circuitos y consume menos energía, explica.

Bates ha colaborado con el Laboratorio Nacional Sandía, la Universidad de Carnegie Mellon, la Oficina de Investigación Naval y el Instituto Tecnológico de Massachusetts (todos en EEUU) en unas pruebas. El objetivo era demostrar que las operaciones inexactas del chip S1 podrían aumentar la eficiencia de determinadas tareas de computación complejas. Los problemas con datos que aportan el ruido del mundo real, o donde se necesite alguna aproximación son los usos más adecuados. Bates afirma que sus resultados son prometedores para aplicaciones como la imágenes de radar de alta resolución, extraer información en 3D de las imágenes estereoscópicas y el aprendizaje profundo, que ha generado un reciente auge de progresos en la inteligencia artificial (IA).

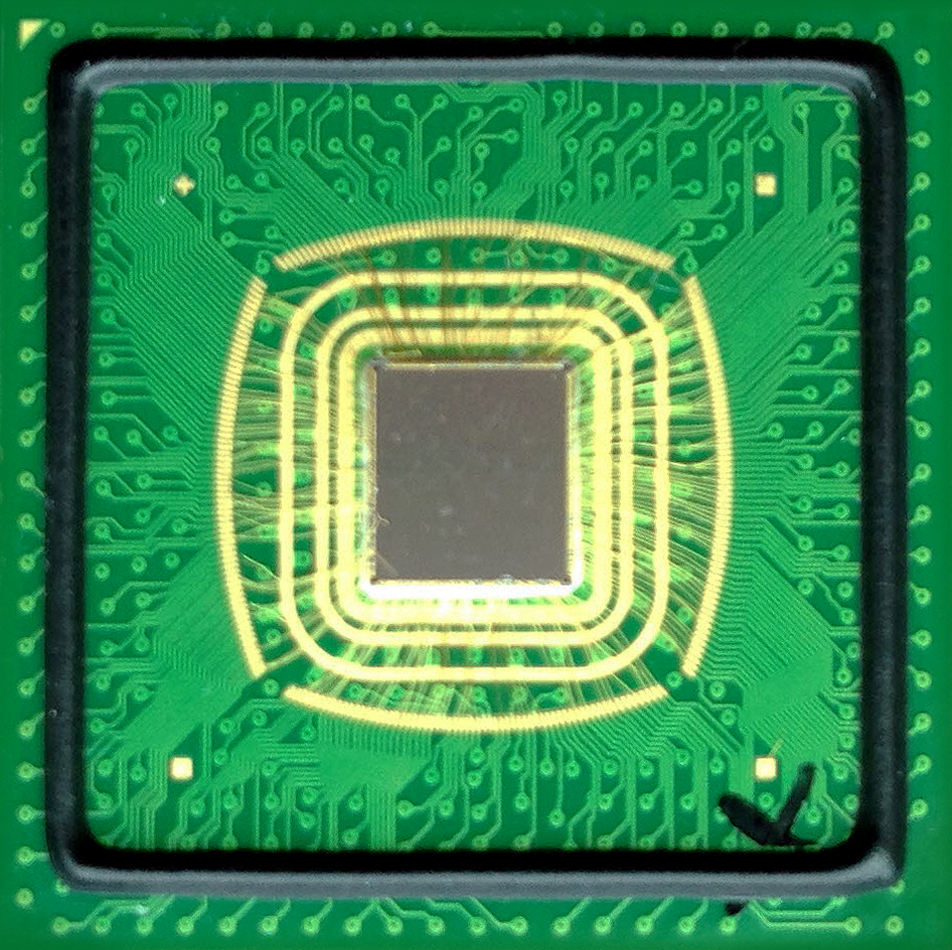

Foto: Este chip no consigue acertar con la aritmética, pero podría conseguir que los ordenadores sean más eficientes en problemas difíciles como analizar imágenes. Crédito: Singular Computing.

Foto: Este chip no consigue acertar con la aritmética, pero podría conseguir que los ordenadores sean más eficientes en problemas difíciles como analizar imágenes. Crédito: Singular Computing.

En una prueba simulada con un software que rastrea los objetos dentro de un vídeo, el enfoque de Singular Computing fue capaz de procesar fotogramas casi 100 veces más rápido que un procesador convencional diseñado para ejecutar correctamente los cálculos. Además, su consumo energético fue inferior al 2% que el de sus homólogos precisos.

Bates no es el primero en estudiar la idea de utilizar hardware menos preciso para procesar los datos con mayor eficacia, una idea conocida como computación aproximada (ver Las 10 Tecnologías Emergentes de 2008: Chips probabilísticos (en inglés)). Pero la inversión de DARPA en su chip podría proporcionar al sueño de las matemáticas difusas su mayor prueba hasta la fecha.

Bates está desarrollando una remesa de ordenadores propensos al error. Cada uno de ellos combina 16 de sus chips con un único procesador convencional. DARPA recibirá cinco de estas máquinas en algún momento del próximo verano y tiene planes de hacerlos disponibles en internet para que los investigadores jueguen con ellos. Se espera que puedan demostrar el potencial de la tecnología y atraer el interés de la industria de chips.

DARPA financió el chip de Singular Computing como parte de un programa llamado Upside dirigido a inventar maneras nuevas y más eficientes de procesar las imágenes de vídeo. Los drones militares pueden recopilar vastas cantidades de vídeo, pero no siempre pueden ser descargadas durante el vuelo. Y la potencia computacional que se necesita para procesarlo en vuelo resultaría demasiado grande.

Pero dar con un hardware preciso requerirá importantes hazañas de software y hasta de ingeniería cultural. No resulta fácil que los programadores acostumbrados a la idea de que los chips siempre son superprecisos se adapten a los que no lo sean, explica el profesor de la Escuela Politécnica federal de Lausana (Suiza) Christian Enz, que ha desarrollado sus propios chips de computación aproximada. Enz afirma que para lograrlo serán necesarias nuevas herramientas.

Pero el profesor del Media Lab del MIT y director científico de Medios de Twitter, Deb Roy, asegura que las tendencias recientes en la computación sugieren que la aproximada podría encontrar un público más dispuesto que nunca. "Existe una resonancia natural cuando se procesa cualquier tipo de dato con ruido", explica. Eso se ha vuelto cada vez más común mientras los programadores buscan extraer informaciones de fotos y vídeos, o lograr que las máquinas entiendan el mundo y el comportamiento humano, según Roy.