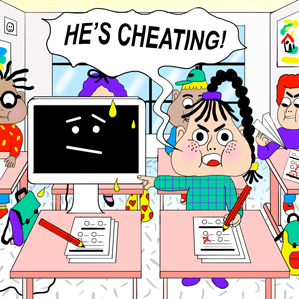

El software de inteligencia artificial Aristo está siendo entrenado para superar un examen oficial de cuarto curso. Otros expertos dudan de que ese sea el mejor sistema para medir el sentido común

¿Durante qué temporada del año tendría mayor grosor el pelo de un conejo? Un programa informático llamado Aristo puede contestar esta pregunta porque leyó sobre los osos y como su pelaje se espesa durante el invierno en una guía de estudios de cuarto de primaria, y sabe que los conejos también son mamíferos. Está estudiando para realizar el examen estandarizado estatal de ciencias de Nueva York (EEUU).

Aristo está siendo desarrollado por investigadores del Instituto Allen para la Inteligencia Artificial de Seattle (EEUU) que quieren dotar a las máquinas de un grado de sentido común acerca del mundo. El CEO del centro, Oren Etzioni, dice que la mejor manera de establecer un punto de referencia para el desarrollo de sus proles digitales es utilizar los exámenes diseñados para los alumnos escolares. Intenta convencer a otros investigadores de inteligencia artificial para que adopten los exámenes estandarizados como método de medir los progresos dentro del campo.

"Podemos colocar nuestro entendimiento de los progresos de la inteligencia artificial sobre una base objetiva", dice Etzioni. Poder comparar los méritos de distintos enfoques debería facilitar que se identifiquen enfoques prometedores y podría acelerar los progresos, afirma.

A principios de octubre, el Instituto Allen lanzará una competición que reta a los investigadores a desarrollar software que aborde preguntas de ciencia de segundo de la ESO. La competición se celebrará en las instalaciones de la página web de la empresa de ciencia de datos Kaggle, donde los participantes tendrán acceso a miles de preguntas de ensayo para entrenar su software. Se premiará con 50.000 dólares (unos 45.000 euros) al creador del software que consiga el mejor resultado con preguntas que no ha visto con anterioridad.

Ahora mismo, Aristo ni se acerca al aprobado con el examen de ciencias de cuarto de primaria. Eso requeriría una puntuación del 65%. Aristo sólo es capaz de contestar preguntas de respuesta múltiple, que representan dos terceras partes del examen. Consigue acertar en aproximadamente el 75% de las preguntas que no incluyen diagramas, y en el 45% de las que sí, dice Etzioni. Aristo consigue una puntuación del 63% en preguntas de respuesta múltiple sin diagramas de segundo de la ESO.

Puedes observar a Aristo contestar una selección de preguntas de cuarto de primaria en la página web del Instituto Allen. El software emplea algoritmos de razonamiento para contestar las preguntas utilizando conocimientos adquiridos de las guías de estudio e internet.

Encontrar la manera de introducir hasta una pizca de sentido común al software representa un importante reto de la inteligencia artificial, y uno que podría dar paso a que los ordenadores nos asistiesen de muchas maneras nuevas. "Si queremos desarrollar sistemas robustos y que resulten más naturales a la hora de ser empleados por humanos, necesitarán disponer de estas cualidades", explica Etzioni.

Es una opinión que comparten otros investigadores líderes, incluido el laboratorio en expansión de inteligencia artificial de Facebook, que quiere habilitar asistentes virtuales capaces de mantener una conversación básica (ver El hombre que enseña a las máquinas a entender el lenguaje). Uno de los motivos por los que los asistentes virtuales existentes, como Siri de Apple o Cortana de Microsoft, son muy limitados es que deben apañárselas sin disponer de un sentido común. Utilizan lo que dices para realizar una selección desde un portfolio de reglas preprogramadas.

Ernest Davis, un profesor de la Universidad de Nueva York está de acuerdo en que la manera de establecer un punto de referencia para el sentido común de una máquina podría impulsar el campo. Pero no cree que la utilización de exámenes escolares sea una buena elección.

La utilización de exámenes diseñados para niños tiene la ventaja de asegurar que los investigadores no fijen, ni por accidente ni a propósito, el punto de referencia demasiado bajo, explica. Pero puesto que a los niños se les da mucho mejor entender el mundo que las máquinas, los exámenes diseñados para ellos no pueden ser utilizados para explorar las habilidades más importantes para lograr progresos con software inteligente, dice.

"Lo que resulta difícil para los humanos es muy diferente a lo que resulta difícil para las máquinas", dice Davis, que también trabaja en proporcionar sentido común al software. "Los exámenes estandarizados no disponen de una buena cobertura de los problemas que resultan difíciles para los ordenadores".

Según Davis, una alternativa mejor sería diseñar preguntas del estilo de examen específicamente para las máquinas. Un ejemplo de este tipo de pregunta diseñada por Davis sugiere que un examen de ciencias diseñada expresamente para una máquina podría parecerle muy básico a un alumno de cuarto de primaria: "La vaca preferida de Sally murió ayer. La vaca probablemente estará viva de nuevo a) mañana; b) dentro de una semana; c) dentro de un año; d) dentro de varios años; e) la vaca nunca volverá a estar viva".

Etzioni contesta que aunque las preguntas de exámenes escolares no evalúan de forma directa el sentido común más básico, lo requieren de una forma implícita, porque se emplea a la hora de interpretar las preguntas. Sólo podremos afirmar que estamos midiendo las máquinas con nuestros propios estándares mediante el uso de preguntas diseñadas para los humanos, afirma. "Colocar a los humanos y las máquinas sobre la misma base objetiva tiene sentido".