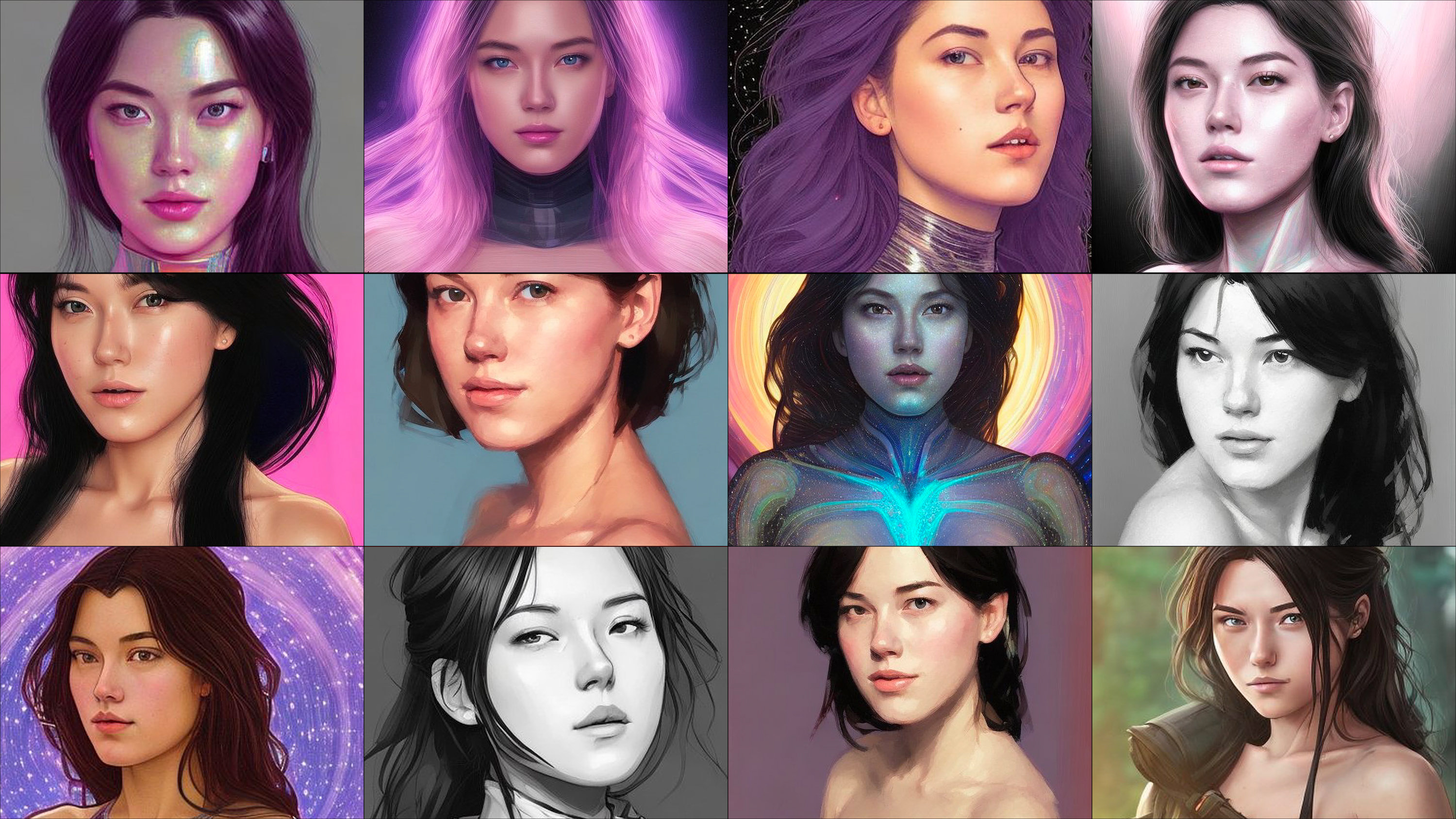

Mis avatares fueron pornográficos caricaturescos, mientras que mis colegas masculinos se convirtieron en astronautas, exploradores e inventores.

Cuando probé Lensa, la nueva aplicación viral de avatar de inteligencia artificial, esperaba obtener resultados similares a los de algunos de mis colegas de MIT Technology Review. La aplicación de retoque digital se lanzó por primera vez en 2018, pero recientemente se volvió muy popular gracias a la incorporación de Magic Avatars, una función impulsada por IA que genera retratos digitales de personas en función de sus selfies.

Pero aunque Lensa generó avatares realistas pero halagadores para ellos (piensa en astronautas, guerreros feroces y fotos de portada geniales para álbumes de música electrónica), obtuve toneladas de desnudos. De los 100 avatares que generé, 16 estaban en topless, y en otros 14 me habían puesto ropa extremadamente diminuta y poses abiertamente sexualizadas.

Tengo ascendencia asiática, y eso parece ser lo único que el modelo de IA captó de mis selfies. Obtuve imágenes de mujeres asiáticas genéricas claramente modeladas en personajes de anime o videojuegos. O muy probablemente porno, teniendo en cuenta la gran cantidad de mis avatares que estaban desnudos o mostraban mucha piel. Un par de mis avatares parecían estar llorando. Mi colega blanca obtuvo significativamente menos imágenes sexualizadas, con solo un par de desnudos y toques de escote. Otro colega con ascendencia china obtuvo resultados similares a los míos: montones y montones de avatares pornográficos.

El fetiche de Lensa por las mujeres asiáticas es tan fuerte que obtuve desnudos femeninos y poses sexualizadas incluso cuando dirigí la aplicación para generar avatares de mí como hombre.

El hecho de que mis resultados estén tan hipersexualizados no es sorprendente, dice Aylin Caliskan, profesora asistente en la Universidad de Washington que estudia los sesgos y la representación en los sistemas de IA.

Lensa genera sus avatares utilizando Stable Diffusion , un modelo de IA de código abierto que genera imágenes basadas en indicaciones de texto. Stable Diffusion se construye utilizando LAION-5B, un conjunto masivo de datos de código abierto que se ha compilado extrayendo imágenes de Internet.

Y debido a que Internet está repleto de imágenes de mujeres desnudas o apenas vestidas, e imágenes que reflejan estereotipos sexistas y racistas, el conjunto de datos también está sesgado hacia este tipo de imágenes.

Esto conduce a modelos de IA que sexualizan a las mujeres independientemente de si quieren ser representadas de esa manera, dice Caliskan, especialmente mujeres con identidades que históricamente han estado en desventaja.

Los datos de entrenamiento de IA están llenos de estereotipos racistas, pornografía e imágenes explícitas de violaciones, según descubrieron los investigadores Abeba Birhane, Vinay Uday Prabhu y Emmanuel Kahembwe después de analizar un conjunto de datos similar al que se usó para construir Stable Diffusion. Es notable que sus hallazgos solo fueron posibles porque el conjunto de datos LAION es de código abierto. La mayoría de las otras IA de creación de imágenes populares, como Imagen de Google y DALL-E de OpenAI, no son abiertas, pero se construyen de manera similar, utilizando tipos similares de datos de entrenamiento, lo que sugiere que este es un problema de todo el sector.

Como informé en septiembre, cuando acababa de lanzarse la primera versión de Stable Diffusion, la búsqueda de palabras clave como "asiático" en el conjunto de datos del modelo arrojó casi exclusivamente pornografía.

Stability.AI, la empresa que desarrolló Stable Diffusion, lanzó una nueva versión del modelo de IA a fines de noviembre. Un portavoz dice que el modelo original se lanzó con un filtro de seguridad, que Lensa no parece haber usado, ya que eliminaría estas salidas. Una forma en que Stable Diffusion 2.0 filtra el contenido es eliminando las imágenes que se repiten con frecuencia. Cuanto más a menudo se repite algo, como las mujeres asiáticas en escenas sexualmente gráficas, más fuerte se vuelve la asociación en el modelo de IA.

Caliskan ha estudiado CLIP (preentrenamiento de imágenes de lenguaje contrastivo), que es un sistema que ayuda a Stable Diffusion a generar imágenes. CLIP aprende a relacionar imágenes en un conjunto de datos con indicaciones de texto descriptivo. Caliskan descubrió que estaba lleno de prejuicios raciales y de género problemáticos.

“Las mujeres se asocian con contenido sexual, mientras que los hombres se asocian con contenido profesional relacionado con la carrera en cualquier dominio importante, como medicina, ciencia, negocios, etc.”, dice Caliskan.

Curiosamente, mis avatares de Lensa eran más realistas cuando mis imágenes pasaban por filtros de contenido masculino. Obtuve avatares de mí mismo usando ropa (!) y en poses neutrales. En varias imágenes, llevaba una bata blanca que parecía pertenecer a un chef o un médico.

Pero no son solo los datos de entrenamiento los que tienen la culpa. Las empresas que desarrollan estos modelos y aplicaciones toman decisiones activas sobre cómo usan los datos, dice Ryan Steed, estudiante de doctorado en la Universidad Carnegie Mellon, que ha estudiadolos sesgos en los algoritmos de generación de imágenes .

“Alguien tiene que elegir los datos de entrenamiento, decidir construir el modelo, decidir tomar ciertos pasos para mitigar esos sesgos o no”, dice.

Los desarrolladores de la aplicación han elegido que los avatares masculinos aparezcan en trajes espaciales, mientras que los avatares femeninos obtengan tangas cósmicas y alas de hadas.

Un portavoz de Prisma Labs dice que la "sexualización esporádica" de las fotos le sucede a personas de todos los géneros, pero de diferentes maneras.

La compañía dice que debido a que Stable Diffusion está capacitado con datos sin filtrar de Internet, ni ellos ni Stability.AI, la compañía detrás de Stable Diffusion, "podrían aplicar conscientemente cualquier sesgo de representación o integrar intencionalmente elementos de belleza convencionales".

“Los datos en línea hechos por el hombre y sin filtrar introdujeron el modelo a los sesgos existentes de la humanidad”, dice el portavoz.

A pesar de eso, la compañía afirma que está trabajando para tratar de abordar el problema.

En una publicación de blog , Prisma Labs dice que ha adaptado la relación entre ciertas palabras e imágenes de una manera que apunta a reducir los sesgos, pero el portavoz no entró en más detalles. Stable Diffusion también ha dificultado la generación de contenido gráfico, y los creadores de la base de datos LAION han introducido filtros NSFW.

Lensa es la primera aplicación enormemente popular desarrollada a partir de Stable Diffusion, y no será la última. Puede parecer divertido e inocente, pero no hay nada que impida que las personas lo usen para generar imágenes de mujeres desnudas no consensuales basadas en sus imágenes de redes sociales, o para crear imágenes de niños desnudos . Los estereotipos y prejuicios que está ayudando a incrustar aún más también pueden ser muy perjudiciales para la forma en que las mujeres y las niñas se ven a sí mismas y cómo las ven los demás, dice Caliskan.

“En 1000 años, cuando miremos hacia atrás mientras generamos la huella digital de nuestra sociedad y cultura en este momento a través de estas imágenes, ¿es así como queremos ver a las mujeres?” ella dice.