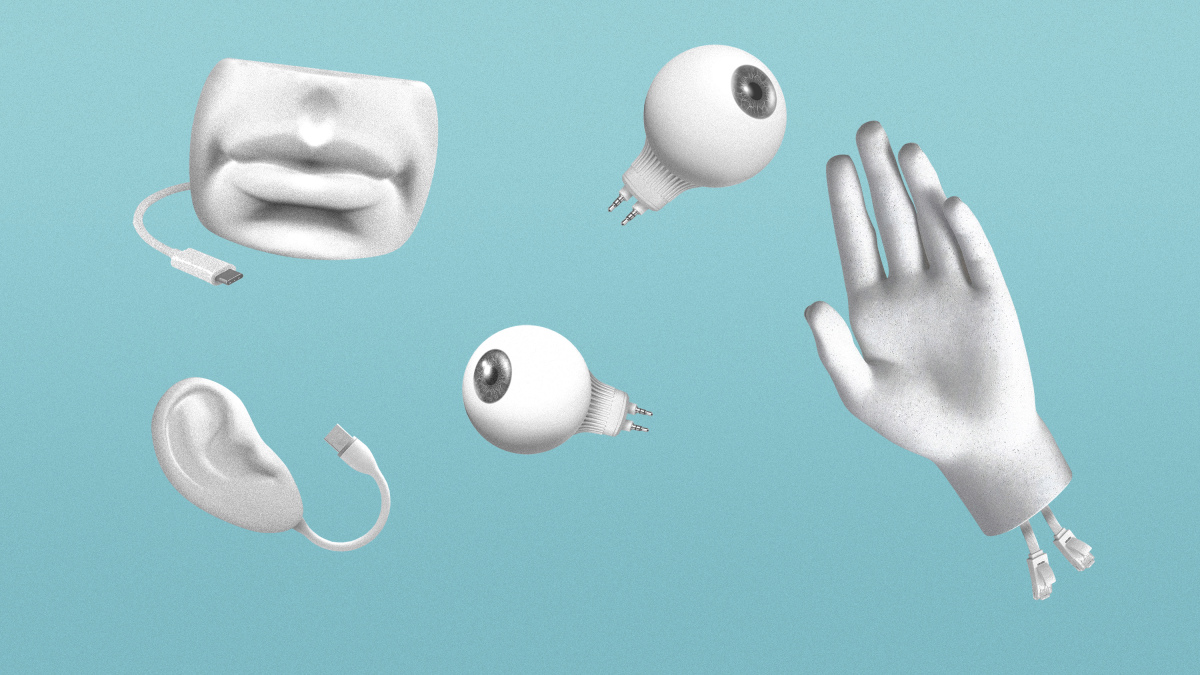

La inteligencia humana surge de nuestra combinación de sentidos y habilidades lingüísticas. Quizás ese mismo enfoque se pueda aplicar para la inteligencia artificial.

-

¿Qué? La inteligencia humana surge de una combinación de sentidos y habilidades lingüísticas, un enfoque que podría llevar a la IA al siguiente nivel.

-

¿Por qué? La IA capaz de sentir y hablar sería mucho mejor para afrontar los nuevos desafíos y trabajar junto a las personas.

-

¿Quién? OpenAI, AI2 y Facebook.

-

¿Cuándo? Ya.

A finales de 2012, los científicos de inteligencia artificial (IA) descubrieron qué tenían que hacer para que las redes neuronales pudieran "ver". Demostraron que el software diseñado para imitar libremente el cerebro humano podría mejorar drásticamente los sistemas de visión artificial existentes. Desde entonces, este campo ha aprendido a provocar que las redes neuronales imiten la forma en la que razonamos, escuchamos, hablamos y escribimos.

Pero, aunque la IA se ha vuelto notablemente parecida a la inteligencia humana, incluso sobrehumana, para desempeñar tareas específicas, todavía no refleja la flexibilidad del cerebro humano. Las personas somos capaces de aprender habilidades en un contexto y aplicarlas en otro. En cambio, aunque el algoritmo de juego AlphaGo de DeepMind puede vencer a los mejores jugadores del Go del mundo, no puede extender esa estrategia más allá del tablero. Los algoritmos de aprendizaje profundo, en otras palabras, son maestros en entender patrones, pero no pueden comprender nuestro mundo cambiante ni adaptarse a él.

Los investigadores tienen muchas hipótesis sobre cómo se podría superar este problema, pero una en concreto ha ganado terreno sobre las demás. Los niños aprenden sobre el mundo sintiéndolo y hablando de él. La combinación de ambas facetas parece clave. A medida que los niños comienzan a asociar palabras con imágenes, sonidos y otra información sensorial, son capaces de describir fenómenos y dinámicas cada vez más complicados, diferenciar lo que es causal de lo que refleja solo correlación y construir un modelo sofisticado del mundo. Luego, ese modelo les ayuda a navegar por entornos desconocidos y a poner en contexto nuevos conocimientos y experiencias.

Los sistemas de IA, por otro lado, están diseñados para hacer solo una de estas cosas a la vez. Los algoritmos de visión por ordenador y reconocimiento de audio pueden detectar cosas, pero no son capaces de usar el lenguaje para describirlas. Un modelo de lenguaje natural puede manipular las palabras, pero esas palabras son ajenas a cualquier realidad sensorial. Si se combinaran los sentidos y el lenguaje para darle a la IA una forma más similar a la humana de reunir y procesar nueva información, ¿acaso al final la IA podría desarrollar algo parecido a una comprensión del mundo?

La esperanza es que estos sistemas "multimodales", con acceso a los "modos" sensoriales y lingüísticos de la inteligencia humana, den lugar a un tipo de IA más sólido capaz de adaptarse más fácilmente a nuevas situaciones o problemas. Estos algoritmos podrían ayudarnos a abordar problemas más complejos o transferirse a robots para comunicarse y colaborar con nosotros en nuestra vida diaria.

Los nuevos avances en los algoritmos de procesamiento de lenguaje como el GPT-3 de OpenAI también han ayudado. Los investigadores ya saben cómo replicar la manipulación del lenguaje lo suficientemente bien para que su combinación con las capacidades de observación resulte más fructífera. Para empezar, están utilizando la primera capacidad de detección que logró el campo: la visión por ordenador. Los resultados son simples modelos bimodales o de inteligencia artificial de lenguaje e información visual.

El año pasado, hubo varios resultados interesantes en esta área. En septiembre, los investigadores del Instituto Allen de Inteligencia Artificial, AI2, crearon un modelo capaz de generar una imagen a partir de un pie de foto, lo que demuestra la capacidad del algoritmo de asociar las palabras con la información visual. En noviembre, los investigadores de la Universidad de Carolina del Norte en Chapel Hill (EE. UU.) desarrollaron un método que incorpora imágenes en los modelos de lenguaje existentes, lo que impulsó la comprensión lectora de los modelos.

OpenAI luego usó estas ideas para ampliar su sistema GPT-3. A principios de 2021, el laboratorio lanzó dos modelos que combinan lenguaje e información visual. Uno vincula los objetos de una imagen con las palabras que los describen en un pie de foto. El otro genera imágenes a partir de una combinación de los conceptos que ha aprendido. Se le puede pedir, por ejemplo, que genere "un cuadro de un carpincho en un campo al amanecer". Aunque es posible que nunca haya visto algo así, el modelo puede mezclar y combinar lo que sabe de los cuadros, carpinchos, campos y amaneceres para crear docenas de ejemplos.

Los sistemas multimodales más sofisticados también harán posibles asistentes robóticos más avanzados (como robots mayordomos, no solo Alexa). La generación actual de robots con tecnología de inteligencia artificial utiliza principalmente datos visuales para navegar e interactuar con su entorno. Eso es bueno para completar tareas simples en entornos reducidos, como los pedidos en un almacén. Pero los laboratorios como AI2 están trabajando para añadir el lenguaje e incorporar más información sensorial, como audio y datos táctiles, para que las máquinas puedan entender los comandos y realizar operaciones más complejas, como abrir una puerta cuando alguien llama.

Más adelante, los avances multimodales podrían ayudar a superar algunas de las mayores limitaciones de la IA. Los expertos argumentan, por ejemplo, que su incapacidad para comprender el mundo también es la razón por la que puede fallar o ser engañada fácilmente. (Una imagen puede ser alterada de una imperceptible para los humanos pero que una IA podría identificar como algo completamente diferente). Lograr una inteligencia más flexible no solo abriría el camino para las nuevas aplicaciones de IA, también las haría más seguras. Los algoritmos que repasan los currículums no tratarían algunas características irrelevantes como el género y la raza como indicadores de capacidad. Los coches autónomos no perderían el rumbo en entornos desconocidos y no se estrellarían en la oscuridad o en la nieve. Los sistemas multimodales podrían convertirse en la primera IA a la que realmente podríamos confiar nuestras vidas.