Cada vez hay más empresas especializadas en ayudar a otras a entender el riesgo e impacto legal y ético de sus sistemas de inteligencia artificial. Después de analizar el funcionamiento de los algoritmos, estas compañías ofrecen soluciones y herramientas para mitigar todo tipo de sesgos

El trabajo de la jefa de "Inteligencia Artificial (IA) Responsable" de la consultora Accenture, Rumman Chowdhury, incluía mucha labor de traducción. Trabajaba con clientes que tenían dificultades para comprender sus modelos de IA. ¿Cómo podían saber si los algoritmos estaban haciendo lo que se suponía que debían hacer? La confusión a menudo se debía a que los científicos de datos, abogados y ejecutivos de la empresa parecían hablar diferentes idiomas. El equipo de Chowdhury actuaba como intermediario para que todas las partes estuvieran alineadas. Era bastante ineficiente: auditar un modelo podía llevar meses.

Pero, a finales de 2020, Chowdhury dejó su puesto para crear su propia empresa, Parity AI, que ofrece a los clientes un conjunto de herramientas diseñadas para acortar el proceso a unas pocas semanas. Primero les ayuda a identificar cómo quieren auditar su modelo (¿por sesgo o por cumplimiento legal?) y luego les ofrece recomendaciones para abordar el problema.

Parity pertenece a un creciente campo de start-ups especializadas en desarrollar, controlar y corregir los modelos de IA de las empresas. Ofrecen una variedad de productos y servicios, desde herramientas de mitigación de sesgos hasta plataformas de explicabilidad. Al principio, la mayoría de sus clientes provenían de industrias fuertemente reguladas como las finanzas y la atención médica.

Pero el aumento de la investigación y de la atención de los medios a las cuestiones de sesgo, privacidad y transparencia han cambiado el enfoque. Los nuevos clientes a menudo simplemente quieren ser responsables, mientras que otros quieren "prepararse para el futuro" anticipándose a la regulación. "Muchas empresas se están enfrentando a este tema por primera vez. Casi todas piden ayuda", asegura Chowdhury.

Del riesgo al impacto

Cuando trabaja con nuevos clientes, Chowdhury evita usar el término "responsabilidad". Le parece demasiado flexible y mal definido; deja demasiado espacio para malentendidos. En cambio, empieza con un lenguaje corporativo más familiar: con el concepto del riesgo. Muchas empresas tienen departamentos de riesgo y cumplimiento, y han establecido procesos para la mitigación del riesgo.

La mitigación del riesgo a través de la IA funciona igual. Para empezar el proceso, la empresa debe tener en cuenta los aspectos que le preocupan, como el riesgo legal, la posibilidad de violar la ley; el riesgo organizacional, la posibilidad de perder empleados; o el riesgo reputacional, la posibilidad de sufrir un desastre de relaciones públicas. A partir de ahí, la compañía puede trabajar hacia atrás para decidir cómo auditar sus sistemas de inteligencia artificial.

Una empresa financiera, que opera bajo las leyes de préstamos justos de EE. UU., debería verificar si existe algún sesgo en sus modelos de préstamos para mitigar el riesgo legal. Una empresa de telesalud, cuyos sistemas se entrenan con datos médicos confidenciales, podría realizar auditorías de privacidad para mitigar el riesgo relacionado con su reputación.

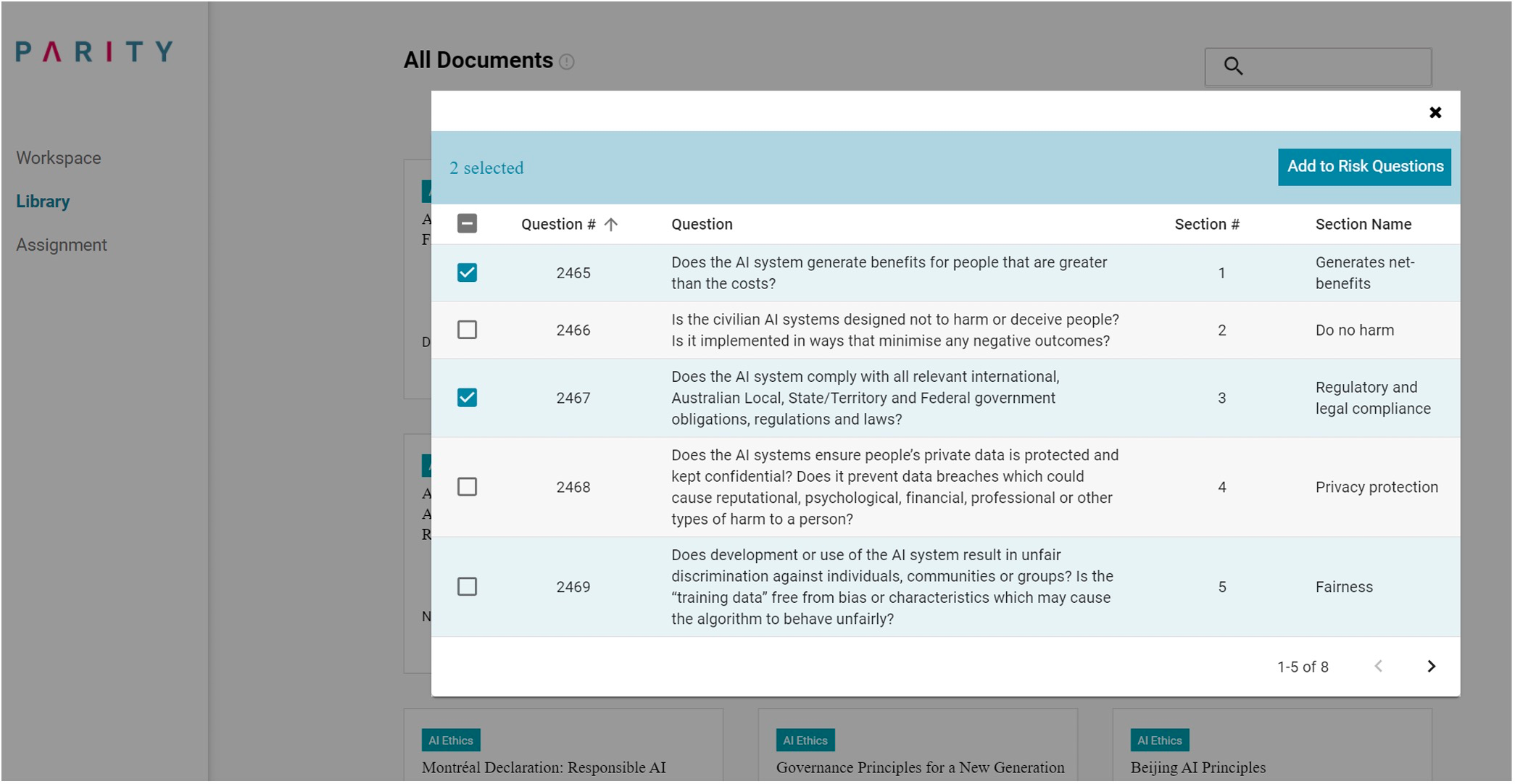

Foto: Parity incluye una biblioteca de preguntas sugeridas para ayudar a las empresas a evaluar el riesgo de sus modelos de IA. Créditos: Parity

Parity ayuda a organizar este proceso. La plataforma le pide a cada empresa que elabore una evaluación interna del impacto, que básicamente sería una encuesta para analizar cómo operan sus sistemas comerciales y de inteligencia artificial. La empresa puede optar por escribir preguntas personalizadas o seleccionarlas de la biblioteca de Parity, que tiene más de 1.000 indicaciones adaptadas de las pautas éticas de IA y la legislación relevante de todo el mundo.

Después de crear la evaluación, la empresa invita a todos los empleados a completarla en función de su puesto de trabajo y conocimientos. Luego, la plataforma incorpora sus respuestas escritas libremente a un modelo de procesamiento de lenguaje natural que las traduce con la mirada puesta en las principales áreas de riesgo de la empresa. Parity, en otras palabras, hace de intermediario para alinear a científicos de datos y abogados.

A continuación, la plataforma recomienda un conjunto de acciones mitigar riesgos, como la creación de un panel para monitorizar la precisión de un modelo o la implementación de nuevos procedimientos de documentación para rastrear cómo se entrenó y adaptó en cada etapa de su desarrollo. También ofrece un conjunto de marcos y herramientas de código abierto que podrían ayudar, como AI Fairness 360 de IBM para el control de sesgos o Model Cards de Google para la documentación.

Chowdhury espera que las empresas se vuelvan más disciplinadas si logran reducir el tiempo que lleva auditar sus modelos, para llevarlo a cabo con regularidad y frecuencia. Con el tiempo, espera que esto también las ayude a pensar más allá de la mitigación de riesgos. Y explica: "Mi objetivo sigiloso es que más empresas piensen en el impacto y no solo en el riesgo. El riesgo es lo que la gente entiende hoy en día, y es algo muy valioso, pero suele ser reactivo y receptivo. El impacto es más proactivo y, en realidad, esa es la mejor manera de plantear lo que deberíamos hacer".

Un ecosistema para la responsabilidad

Mientras que Parity se dedica a la gestión de riesgos, otra start-up, Fiddler, se centra en la explicabilidad. Su CEO Krishna Gade comenzó a pensar en la necesidad de una mayor transparencia en la forma en la que los modelos de inteligencia artificial toman sus decisiones cuando trabajaba como responsable de ingeniería del equipo de News Feed de Facebook. Después de las elecciones presidenciales estadounidenses de 2016, la empresa hizo un gran esfuerzo interno para comprender mejor cómo sus algoritmos clasificaban el contenido. El equipo de Gade desarrolló una herramienta interna que luego se convirtió en la base de la función "¿Por qué veo esto?".

Gade lanzó Fiddler poco después, en octubre de 2018. La empresa ayuda a los equipos de científicos de datos a controlar el desempeño de sus modelos en evolución y crea informes de alto nivel para directivos de negocios en función de los resultados. Si la precisión de un modelo empeora con el tiempo, o muestra comportamientos sesgados, Fiddler ayuda a encontrar la causa. Gade ve los modelos de monitorización y la mejora de la explicabilidad como los primeros pasos para desarrollar e implementar la IA de manera más intencional.

Arthur, fundada en 2019, y Weights & Biases, creada en 2017, son otras dos empresas que ofrecen plataformas de monitorización. Al igual que Fiddler, Arthur se centra en la explicabilidad y en la mitigación de sesgos, mientras que Weights & Biases rastrea los experimentos de aprendizaje automático para mejorar la replicación de la investigación. Las tres empresas han observado un cambio gradual en las principales preocupaciones de las empresas, desde el cumplimiento legal o el desempeño del modelo a la ética y la responsabilidad.

La vicepresidenta de IA responsable de Arthur, Liz O'Sullivan, quien también es directora de tecnología de la organización activista Proyecto de Supervisión de la Tecnología de Vigilancia (Surveillance Technology Oversight Project), cuenta: "Por el lado más escéptico, al principio me preocupaba la posibilidad de que viéramos a los clientes entrar y pensar que simplemente podrían marcar una casilla asociando su marca con otra persona que se encarga de la IA responsable". Pero muchos de los clientes de Arthur han pensado más allá de las soluciones técnicas en sus estructuras de gobierno y enfoques para el diseño inclusivo. "Ha sido muy estimulante ver que realmente están interesados en hacer lo correcto", afirma.

A O'Sullivan y a Chowdhury también les ilusiona ver más start-ups como las suyas. "No hay una sola herramienta o una sola cosa que hay que usar para tener una IA responsable", asegura O'Sullivan. Chowdury está de acuerdo: "Será un ecosistema".