Los vídeos ultrafalsificados han abierto un nuevo campo interpretativo, similar al del doblaje, en el que los actores deben poner su cuerpo, su voz, sus gestos, su acento o simplemente su arte para recrear a otra persona. A pesar de los riesgos de abuso, distintos artistas ven un increíble futuro para la tecnología

En 2019, los artistas multimedia Francesca Panetta y Halsey Burgund tuvieron una provocadora idea. Las ultrafalsificaciones de vídeos y audios conocidos como deepfakes avanzaban imparables, pero aún no se habían integrado en una experiencia completa. Se preguntaban si podrían crear una con la que demostraran todo el potencial de la tecnología y, a la vez, enseñaran a la gente sus posibles malos usos.

Para darle vida al experimento, eligieron un tema igualmente provocador: la historia alternativa del alunizaje del Apolo de 1969. Antes del lanzamiento, los redactores de discursos del entonces presidente de EE. UU., Richard Nixon, habían preparado dos versiones para dirigirse a la nación, una de las cuales se titulaba En caso de desastre lunar, por si la misión no salía según lo planeado. Afortunadamente, Nixon nunca tuvo que pronunciar ese discurso. Pero un deepfake de él sí podría hacerlo.

Así que Panetta, que es directora creativa del Centro para la Virtualidad del MIT (Center for Virtuality), y Burgund, miembro del laboratorio de experimentación con nuevas formas documentales (Open Documentary Lab) del MIT, se asociaron con dos empresas de inteligencia artificial (IA): Canny AI, especializada en vídeos deepfake, y Respeecher, centrada en los audios. Con todos los componentes técnicos organizados, solo necesitaban una última cosa: a un actor que interpretara la escena.

Burgund recuerda: "Teníamos que encontrar a alguien dispuesto a hacerlo, porque era un servicio un poco extraño. A alguien con flexibilidad en su forma de pensar sobre lo que significa ser actor y su trabajo".

Aunque los deepfakes existen desde hace varios años, los castings para interpretar en deepfakes son relativamente nuevos. Las primeras tecnologías de los deepfakes no eran muy buenas, se usaban principalmente en los rincones más oscuros de internet para incrustar el rostro de famosos vídeos pornográfocicos sin su consentimiento. Pero a medida que los deepfakes se han vuelto cada vez más realistas, un mayor número de artistas y cineastas han empezado a utilizarlos en producciones de alta calidad de difusión y en anuncios de televisión. Esto implica contratar a actores reales para distintos aspectos del trabajo. Algunos casos requieren que un actor proporcione su rostro como "base"; otros necesitan la voz.

Así se han abierto algunas posibilidades creativas y profesionales interesantes para los actores. Pero, al mismo tiempo, el trabajo plantea una serie de cuestiones éticas. Burgund detalla: "Es tan nuevo que no existe un procedimiento establecido ni nada de eso. Quiero decir, simplemente estábamos inventándolo todo y avanzando así".

"¿Alguien quiere convertirse en Nixon?"

Lo primero que hicieron Panetta y Burgund fue preguntar a ambas compañías qué tipo de actor necesitaban para crear un buen deepfake. Burgund matiza: "Nos interesaba saber no solo los criterios importantes, sino también los que no lo eran".

Para el trabajo visual, Canny AI se especializa en sustituir los diálogos en un vídeo y utiliza los movimientos de la boca de un actor para manipular la boca de otra persona en un vídeo ya existente. El actor, en otras palabras, sirve de titiritero y nunca aparece en el producto final. El aspecto físico, el género, la edad y el origen étnico de esa persona no importan.

Pero para el audio, Respeecher, que transforma una voz en otra, explicó que les sería más fácil trabajar con un actor que tuviera el tono de voz y acento similar al de Nixon. Con esa indicación, Panetta y Burgund comenzaron a publicar en varios foros de actores y a enviar correos electrónicos a grupos locales. Su pregunta era: "¿Alguien quiere convertirse en Nixon?"

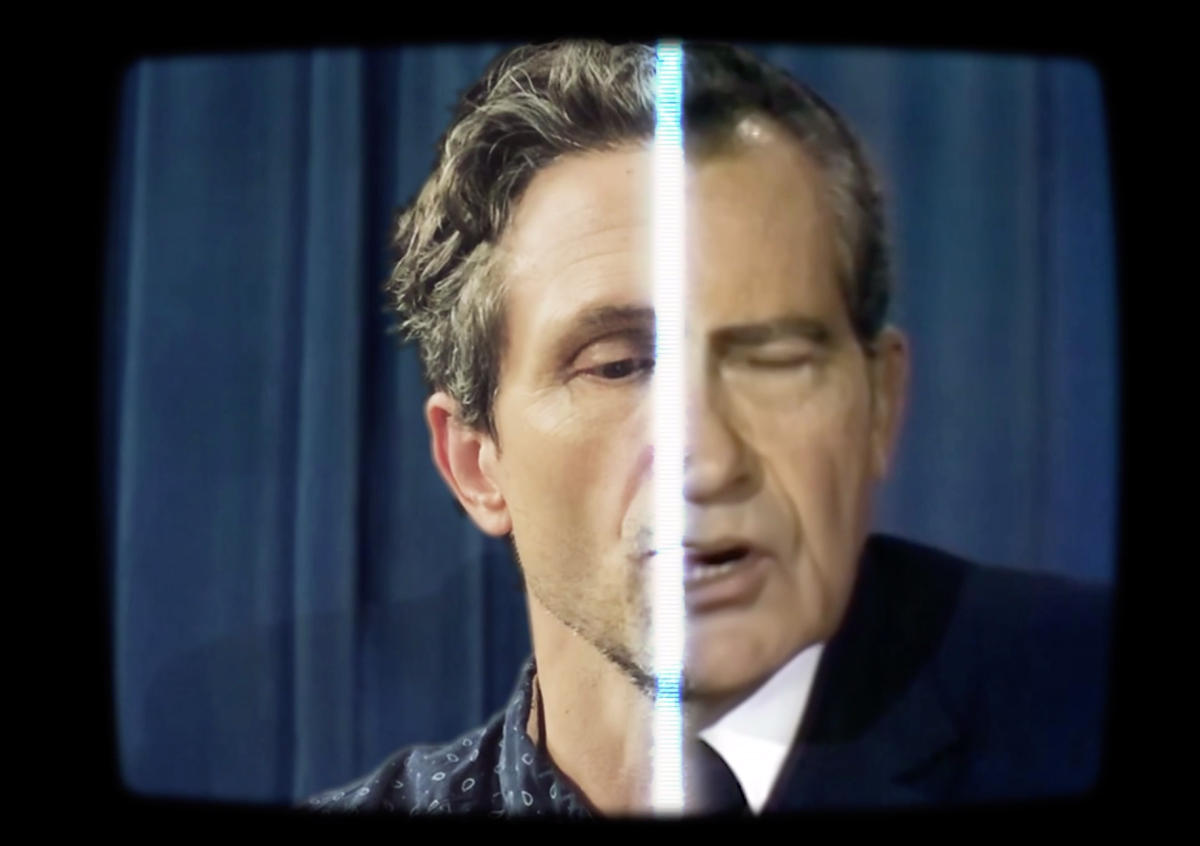

Video: El actor Lewis D. Wheeler pasó varios días en el estudio entrenando los algoritmos de 'deepfake' para mapear su voz y rostro con los de Nixon. Créditos: Panetta y Burgund

Así es como el actor de raza blanca de Boston (EE. UU.) Lewis D. Wheeler acabó encerrado en un estudio durante varios días escuchando y repitiendo partes del audio de Nixon. Había cientos de fragmentos, cada uno de segundos de duración, "de los cuales algunos ni siquiera eran palabras completas", recuerda.

Los fragmentos se habían extraído de varios discursos de Nixon, la mayoría del de su renuncia. Dada la gravedad del discurso del desastre lunar, Respeecher necesitaba material de entrenamiento que capturara el mismo tono sombrío.

El trabajo de Wheeler consistía en volver a grabar cada fragmento con su propia voz, imitando el ritmo y la entonación exactos. Estos pequeños trozos se introducían en el algoritmo de Respeecher para mapear su voz con la de Nixon. "Fue bastante agotador y muy laborioso, pero también interesante, construirlo ladrillo a ladrillo", recuerda.

Vídeo: El 'deepfake' final de Nixon pronunciando el discurso 'En caso de desastre lunar'. Créditos: Panetta y Burgund

La parte visual del deepfake fue mucho más sencilla. En los vídeos de archivo que se iban a manipular, Nixon había pronunciado el discurso real de la llegada a la Luna mirando directamente hacia la cámara. Wheeler solo tenía que pronunciar el discurso alternativo, desde el principio al final, de la misma manera, para que el equipo de montaje capturara los movimientos de su boca en el ángulo correcto.

Como actor, en esa parte empezó a sentirse más cómodo. Al fin y al cabo, su actuación sería la única parte de él que aparecería en el deepfake final. Y añade: "Eso fue lo más desafiante y gratificante. Tuve que profundizar realmente en el pensamiento de ¿de qué trata este discurso? ¿Cómo se le dice al pueblo estadounidense que ha ocurrido esta tragedia? "

"¿Qué impresión nos ha dejado?"

Parece que el productor y director de cine Zach Math trabajaba en un proyecto similar. Había sido contratado por la agencia de producción Mischief USA para dirigir dos anuncios para una campaña por el derecho al voto. Se trataba de versiones deepfake del líder norcoreano, Kim Jong-un, y del presidente ruso, Vladimir Putin, pero el resultado acabó siendo muy diferente al experimento de Panetta y Burgund.

Después de consultar al artista de deepfake John Lee, el equipo de Match optó por intercambiar las caras mediante el software de código abierto DeepFaceLab. Eso significaba que el anuncio final incluiría los cuerpos de los actores, por lo que necesitaban buscar dobles creíbles.

En los anuncios también aparecen las voces reales de los actores, lo que añadió un requisito adicional al casting. El equipo quería que los líderes que aparecieran en los vídeos deepfake hablaran en inglés, pero con auténtico acento norcoreano y ruso. Así que el director de casting buscaba a actores masculinos que se parecieran a cada líder en estatura y estructura facial, que coincidieran con su origen étnico, y capaces de realizar imitaciones de voz convincentes.

Vídeo: El proceso de entrenamiento de DeepFaceLab para generar la cara de Kim Jong-un. Créditos: MISCHIEF USA

Para Putin, el proceso de casting fue relativamente fácil. Hay una gran cantidad de vídeos disponibles de Putin pronunciando discursos, lo que daba al algoritmo bastantes datos de entrenamiento para copiar su rostro con una variedad de expresiones. En consecuencia, había más flexibilidad en cuanto el aspecto físico del actor, porque el deepfake podía realizar la mayor parte del trabajo.

Pero Kim aparece con gafas en la mayoría de los vídeos disponibles y eso oscurecía su rostro y provocaba que el algoritmo fallara. Limitar el material de entrenamiento a los vídeos sin gafas dejó bastante menos información de la que el algoritmo pudo aprender. El deepfake resultante se parecía a Kim, pero los movimientos de su rostro eran menos naturales. Al cambiar el rostro con un actor, las expresiones del actor se perdían.

Para solucionarlo, el equipo comenzó a introducir al software DeepFaceLab todas las cintas de los actores del casting para ver cuál resultaba más convincente. Para su sorpresa, el ganador se parecía menos físicamente a Kim, pero su actuación era más expresiva.

Vídeo: El actor elegido para interpretar a Kim Jong-un tenía el menor parecido físico con el dictador, pero la actuación más expresiva.

Para resolver los detalles del físico de Kim que el deepfake no pudo replicar, el equipo se basó en el maquillaje, el vestuario y el trabajo de posproducción. El actor era más delgado que Kim, por ejemplo, así que tuvo que ponerse un traje con relleno.

A la hora de valorar la calidad del deepfake, Math cree que no se trata de centrarse tanto en los detalles visuales sino en la experiencia. El director explica: "Nunca se decía: '¿Esa oreja parece rara?' Es decir, lo hablábamos. Pero siempre decíamos: 'A ver, ¿qué impresión nos ha dejado?'"

"Actuaban como un escudo humano"

De alguna manera, no hay mucha diferencia entre ser un actor para deepfake y para CGI (Imágenes Generadas por Ordenador), o incluso para el doblaje de dibujos animados. La imagen del actor nunca llega a la producción final, pero el resultado sí que tiene su firma e interpretación. Pero el casting para los deepfakes también puede ir en la otra dirección, con la cara de una persona insertada sobre la actuación de otra.

Conseguir que este tipo de falsificaciones resulte convincente era el propósito del artista de efectos visuales Ryan Laney, quien este año ha trabajado en el documental de HBO Welcome to Chechnya. La película presenta a activistas que arriesgan sus vidas para luchar contra la persecución de las personas LGBTI en esta república rusa. Muchos de ellos viven en secreto por temor a ser torturados y ejecutados.

Para poder contar sus historias, el director David France prometió proteger sus identidades, pero quería hacerlo sin perder su parte humana. Después de probar numerosas opciones, su equipo finalmente se decidió por los deepfakes. Contactó con Laney, quien desarrolló un algoritmo que intercambiaba las caras mientras conservaba las expresiones de la persona original.

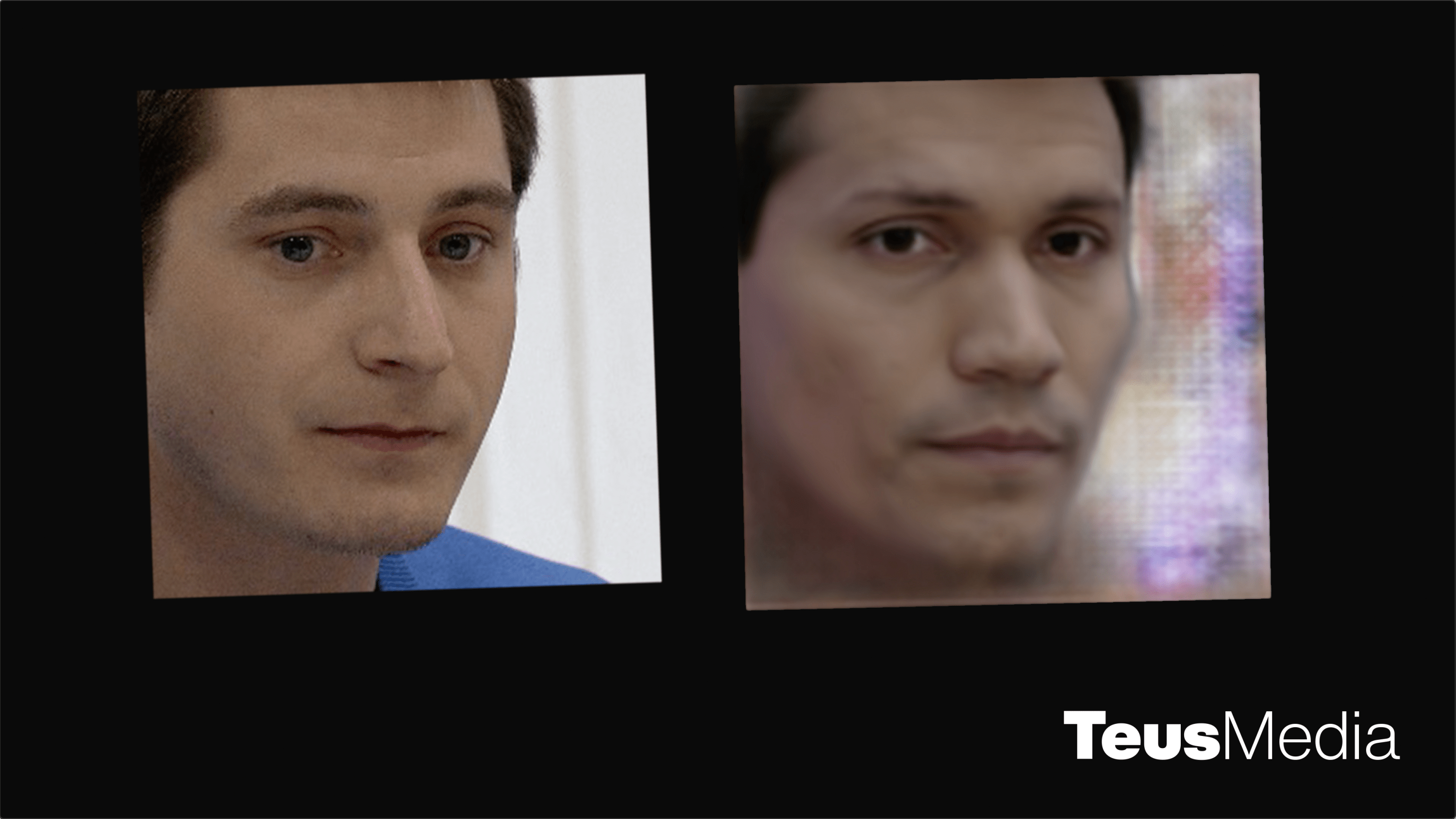

Foto: A la izquierda: el personaje principal del documental Maxim Lapunov, que fue revelado a mitad de la película. A la derecha: el activista latino de la comunidad LGBTI que se ofreció como voluntario para ser el escudo de Maxim. Créditos: TEUS MEDIA

El casting no buscaba actores sino a 23 personas dispuestas a prestar sus rostros a la causa. France finalmente pidió a los activistas de la comunidad LGBTI que se ofrecieran como voluntarios de "tapadera". "No se plantea quién es el mejor actor, sino quiénes están interesados en ese tema porque, en realidad, actuaban como un escudo humano", explica Laney.

El equipo buscó a activistas a través de eventos y publicaciones en Instagram, según su aspecto físico. Cada rostro tenía que ser suficientemente diferente de la persona cuya cara iba a ser sustituida y al mismo tiempo compartir ciertas características. El vello facial, la línea de la mandíbula y la longitud de la nariz, por ejemplo, debían coincidir aproximadamente y las dos personas tenían que ser de la misma edad más o menos para que la cara de la persona que se veía pereciera natural en el cuerpo del sujeto original.

Foto: A la izquierda: el rostro real de Maxim. A la derecha: Maxim con su rostro de deepfake. Créditos: TEUS MEDIA

No obstante, el equipo no siempre hacía coincidir la etnia o el género de las dos personas. El rostro del personaje principal, Maxim Lapunov, que es blanco, fue sustituido por el de un activista latino, y la cara de un personaje femenino fue reemplazada por la de un activista de género no-binario.

Durante todo el proceso, France y Laney se aseguraron de obtener el consentimiento de todas las partes con pleno conocimiento de causa. "Los protagonistas de la película pudieron ver el trabajo antes de que David lo estrenara. Todos tenían que aprobar a su sustituto de cara para garantizar que se sintieran cómodos", afirma Laney.

"Simplemente hace que la gente piense"

Aunque los deepfakes profesionalizados han empujado los límites del arte y de la creatividad, también plantean algunas cuestiones éticas bastante espinosas. Actualmente no hay pautas reales sobre cómo clasificar los deepfakes, por ejemplo, o dónde se encuentra la línea que separa la sátira y la desinformación.

Por ahora, los artistas y cineastas confían en el sentido del bien y del mal de cada persona. France y Laney, por ejemplo, añadieron un aviso de responsabilidad al inicio del documental indicando que algunos personajes habían sido "disfrazados digitalmente" por su propia protección. También agregaron bordes suavizados a los protagonistas con las caras sustituidas para diferenciarlos. "No queríamos tapar a nadie sin que el público lo supiera", asegura Laney.

La artista y productora que crea deepfakes para análisis político Stephanie Lepp también incluye un aviso al principio de sus vídeos para dejar en claro que son falsos. En su serie Deep Reckonings, que imagina a las figuras poderosas como Mark Zuckerberg disculpándose por sus acciones, también usó actores de voz en lugar de audio de deepfake para distinguir aún más el proyecto como una sátira en lugar de un engaño.

Otros proyectos han sido más modestos, como los del artista-activista que trabaja bajo el seudónimo de Bill Posters, Barnaby Francis. A lo largo de los años, Francis ha creado deepfakes de los políticos como Boris Johnson y celebridades como Kim Kardashian, todo en nombre de la educación y la sátira. Pero algunos de los vídeos solo están etiquetados externamente, por ejemplo, en la leyenda cuando Francis los publica en Instagram. Si se sacan de ese contexto, corren el riesgo de difuminar el arte y la realidad, algo que lo ha llevado a veces a un terreno peligroso.

Tampoco hay demasiadas reglas sobre las imágenes y los discursos que se pueden manipular, ni protecciones para los actores detrás de escena. Hasta ahora, la mayoría de los deepfakes profesionalizados se han basado en personajes famosos y se han realizado con objetivos claros y constructivos, por lo que están protegidos legalmente en EE. UU. por las leyes de la sátira. En cambio, en el caso de los deepfakes de Putin y Kim de Mischief, los actores han permanecido en el anonimato por "razones de seguridad personal", según el equipo, debido a la naturaleza controvertida de manipular imágenes de los dos dictadores.

Teniendo en cuenta cómo se han utilizado algunos deepfakes creados por personas no profesionales para abusar, manipular y acosar a las mujeres, algunos creadores también están preocupados por la dirección que podrían tomar las cosas. "Hay muchas personas que se están subiendo al tren, pero que no se preocupan ética o moralmente por quiénes son sus clientes, dónde podría aparecer su trabajo y de qué forma", admite Francis.

Sin embargo, a pesar de estas difíciles cuestiones, muchos artistas y cineastas creen firmemente que los deepfakes se deberían usar en el futuro. Utilizada de forma ética, esta tecnología amplía las posibilidades del arte y de la crítica, de la provocación y de la persuasión. "Simplemente hace que la gente piense. Es la forma de arte perfecta para este tipo de tiempo absurdo, casi surrealista que estamos viviendo", concluye Francis.