Los agentes de inteligencia artificial se dividieron en dos equipos: los que se escondían y los que buscaban. La cooperación y la rivalidad entre ellos dio lugar a sorprendentes estrategias de juego sin que los investigadores les hubieran dado instrucciones para ello

En los primeros días de la vida en la Tierra, los organismos biológicos eran extremadamente simples. Eran criaturas microscópicas unicelulares con poca o ninguna capacidad de coordinación. Sin embargo, tras miles de millones de años de evolución, la rivalidad y la selección natural condujeron a las complejas formas de vida actuales, así como a la también compleja inteligencia humana.

Los investigadores de OpenAI, un laboratorio de investigación de inteligencia artificial (IA), han planteado una hipótesis: ¿si fuéramos capaces de simular ese tipo de rivalidad en un mundo virtual, podríamos producir también una inteligencia artificial mucho más sofisticada?

Su experimento se basa en dos ideas del campo: el entrenamiento de múltiples agentes, la idea de que varios algoritmos compitan o se coordinen para generar nuevos comportamientos, y el aprendizaje reforzado, la técnica específica de aprendizaje automático que aprende a conseguir un objetivo mediante prueba y error. (DeepMind lo popularizó con su innovador programa AlphaGo, que venció al mejor jugador humano en el antiguo juego de mesa chino Go).

En su nuevo artículo, OpenAI ha revelado sus resultados iniciales. Mediante el simple juego del escondite, realizado cientos de millones de veces, dos equipos opuestos de agentes de IA desarrollaron complejas estrategias para esconderse y buscar, que incluían el uso de distintas herramientas y formas de colaboración. La investigación también ofrece información sobre la estrategia de investigación dominante de OpenAI: escalar drásticamente las técnicas de IA existentes para ver qué propiedades surgen.

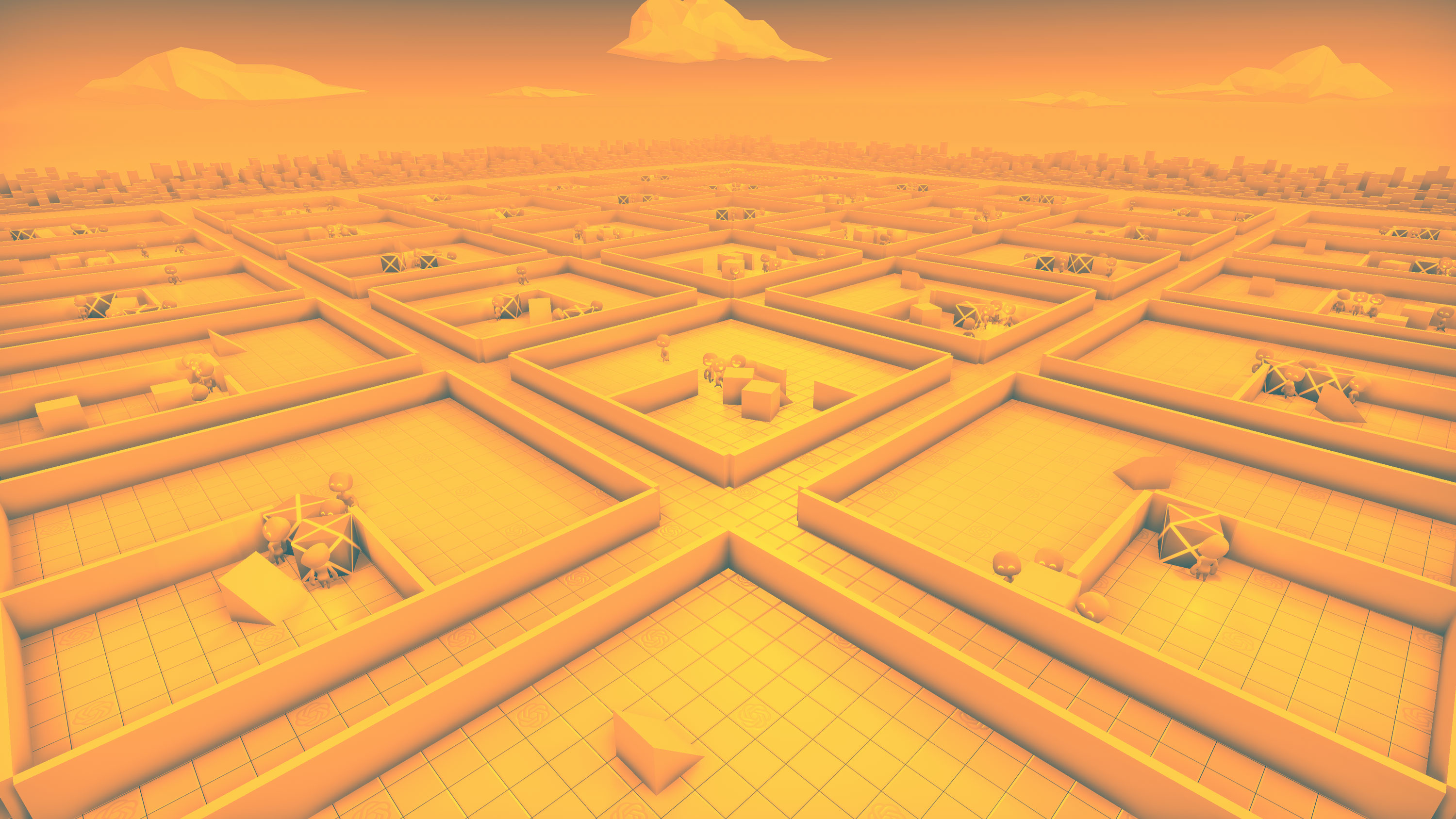

Imagen: Después de aproximadamente 25 millones de rondas, los que se escondían aprendieron a construir fortificaciones para ganar. Créditos: Open AI

Seis fases de estrategia

Para crear el juego, los investigadores diseñaron un entorno virtual consistente en un espacio cerrado con varios objetos como bloques, rampas y barricadas móviles y fijas. Los propios agentes eran controlados por algoritmos de aprendizaje reforzado. Para cada juego, los agentes se dividían en dos equipos: los que se escondían eran recompensados por esquivar a los que los buscaban o penalizados si les encontraban; los buscadores también eran recompensados o penalizados por encontrar o no a los que se escondían. Igual que en el clásico juego del escondite, los que se escondían tenían unos segundos de ventaja. Pero estas fueron las únicas instrucciones que los investigadores dieron a los agentes.

En el transcurso de cientos de millones de rondas, los agentes desarrollaron varias estrategias. Durante la primera fase, sus estrategias para esconderse y buscar eran muy simples y no manipulaban ninguno de los objetos mientras se movían por el espacio.

Foto: En la tercera fase, los buscadores aprendieron a subir por los muros de las fortificaciones mediante una rampa. Créditos: Open AI

Pero cuando llevaban unos 25 millones de rondas, su estrategia se volvió más sofisticada. Los que se escondían aprendieron a moverse y encerrarse entre las cajas y barricadas en el espacio construyendo fortificaciones a su alrededor para que los buscadores no los vieran. Y no solo eso, también desarrollaron estrategias de coordinación, como pasarse objetos entre sí, para acelerar el proceso de construcción.

Después de otros 75 millones de rondas, los buscadores descubrieron una contraestrategia: aprendieron a mover una rampa al lado del fuerte donde se escondían sus rivales y usarla para trepar por las paredes, lo que llevó el experimento a la fase tres. En la fase cuatro, 10 millones de rondas más tarde, los que se escondían aprendieron a bloquear las rampas en un sitio antes de construir su fortaleza. (Ningún equipo podía desbloquear un objeto bloqueado por el equipo contrario).

Al principio, los investigadores de OpenAI creían que esta era la última fase del juego, pero finalmente, al llegar a los 380 millones de rondas, aparecieron dos estrategias más. Los buscadores volvieron a desarrollar una táctica para penetrar en el fuerte de los que se escondían usando una rampa bloqueada para subir a una caja desbloqueada, y luego "surfear" en la parte superior de la caja hacia el fuerte y sobre sus paredes. En la fase final, los que se escondían aprendieron a bloquear todas las rampas y cajas antes de construir su fortaleza.

Foto: Finalmente, después de 380 millones de rondas de entrenamiento, los buscadores aprendieron a "surfear" para escalar los muros de la fortaleza. Créditos: OpenAI

Inteligencia emergente

Los investigadores creen que estos resultados demuestran un nuevo y prometedor enfoque para crear una IA más compleja. El coautor de la investigación Bowen Baker detalla: "No les dimos instrucciones para que se acercaran a una caja o interactuaran con ella. Pero a través la competición entre múltiples agentes les permitió desarrollar nuevas tareas a las que el equipo contrario tenía que adaptarse".

Este estudio refleja el enfoque tan específico de OpenAI para la investigación de IA. Aunque este laboratorio también ha invertido en el desarrollo de técnicas novedosas, se ha labrado su fama a base de escalar drásticamente técnicas existentes. GPT-2, el modelo de lenguaje infame de este laboratorio, por ejemplo, copiaba bastantes elementos del diseño algorítmico de otros modelos de lenguaje anteriores, incluido el BERT de Google; La innovación principal de OpenAI consiste en una maravilla de ingeniería y en amplios recursos computacionales.

En cierto modo, este estudio reafirma el valor de probar los límites de las tecnologías existentes a escala. El equipo planea continuar con esta estrategia. Los investigadores afirman que la primera ronda de experimentos no llegó a alcanzar los límites de los recursos computacionales de los que disponían. Baker concluye: "Queremos que la gente se imagine qué sucedería al introducir este tipo de competencia en un entorno mucho más complejo. Los comportamientos que van aprendiendo podrían llegar a ser capaces de resolver algunos problemas que quizá ahora mismo no sabemos solucionar".