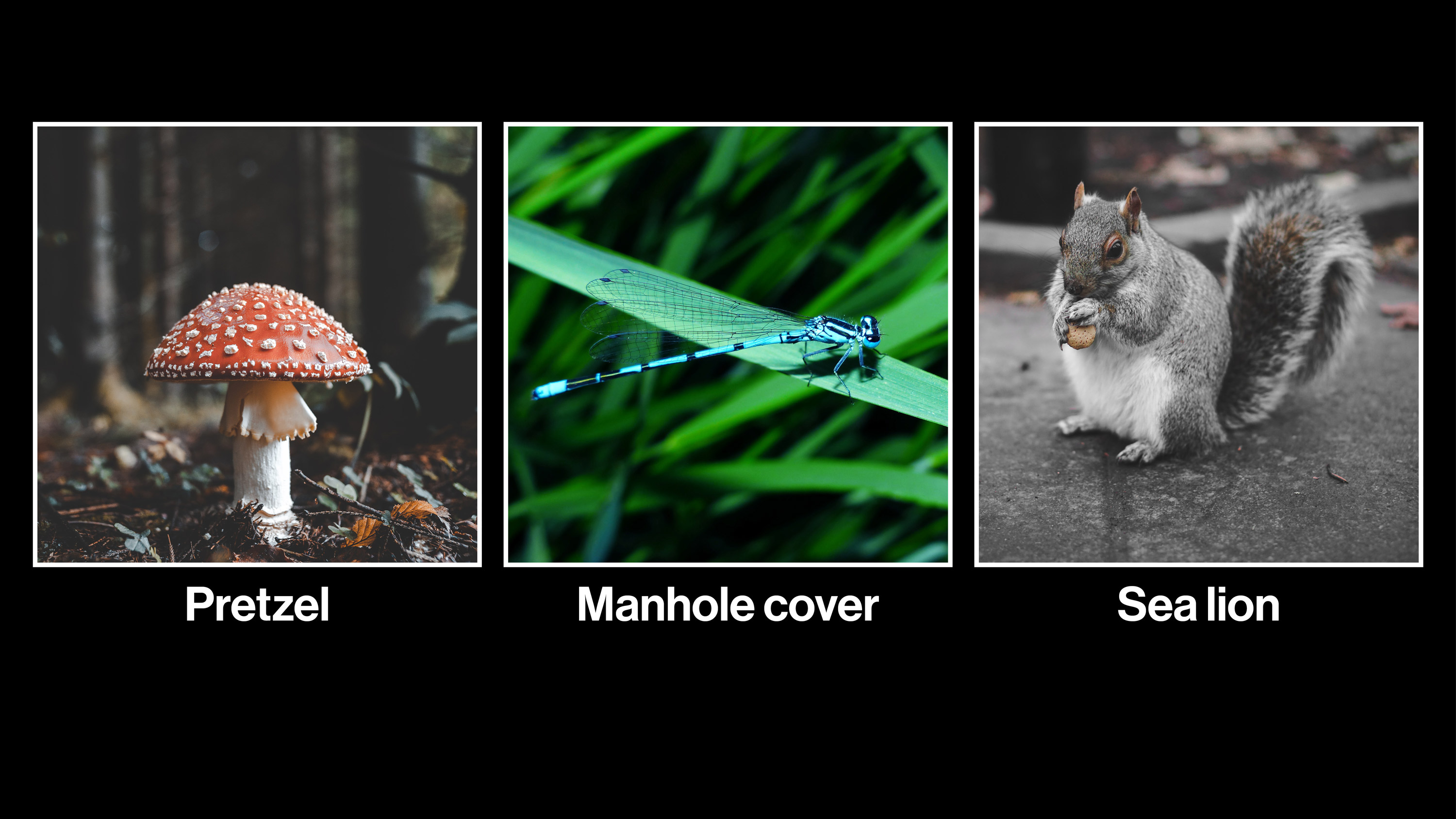

Los sistemas de reconocimiento de imágenes suelen confundir ardillas con leones marinos y libélulas con tapas de alcantarilla. Aunque aún no se sabe por qué pasa, estos errores pueden servir para crear una inteligencia artificial que resista mejor a las imágenes manipuladas

A la inteligencia artificial (IA) se le da muy bien identificar objetos en imágenes, pero todavía se confunde con mucha facilidad. Si se añaden unos cuantos detalles o capas con ruido estático invisible para el ojo humano, el sistema de reconocimiento de imágenes deja de funcionar, y eso a veces puede tener efectos mortales (ver Esta imagen vale más que mil palabras para analizar los riesgos de la conducción autónoma). Si se ponen unos adhesivos a una señal de alto, por ejemplo, un coche autónomo podría confundirla con una señal de límite de velocidad de 75 kilómetros por hora. Si eso ocurriera en una carretera podría provocar que un Tesla se desviara hacia el carril contrario. (En el lado positivo, las mismas técnicas también pueden protegernos de un estado de vigilancia tipo Gran Hermano. Unas veces se gana y otras se pierde).

Todos estos casos se conocen como ejemplos antagónicos, y desde que se conocen, los investigadores luchan para desarrollar formas de proteger los sistemas de inteligencia artificial de ellos. Pero en un artículo del año pasado, un grupo de Google Brain y la Universidad de Princeton (EE. UU.), incluido el padre de las redes generativas antagónicas (GAN), Ian Goodfellow, expresó que estas investigaciones emergentes eran demasiado teóricas y poco acertadas.

Aunque la mayor parte de la investigación se ha centrado en proteger los sistemas frente a las interferencias diseñadas ex profeso, los investigadores creen que los hackers probablemente elegirían una herramienta más contundente: una foto completamente diferente en lugar de un patrón de ruido por capa. Ese método también podría provocar que el sistema funcione mal.

Estas crítica inspiró al estudiante de doctorado de la Universidad de California en Berkeley (EE. UU.) Dan Hendrycks para crear un nuevo conjunto de datos de imágenes a las que ha bautizado "ejemplos antagónicos naturales", que logran engañar a un sistema de IA sin necesidad de ningún retoque especial.

En la muestra aparece una ardilla que los sistemas comunes etiquetan erróneamente como un león marino y una libélula que suelen confundir con una tapa de alcantarilla. "Parece mucho más difícil defenderse de estos ejemplos", resalta. Los ejemplos antagónicos artificiales deben conocer todas las defensas del sistema de IA al que intentan encajar para ser más efectivos. Por su parte, los ejemplos naturales pueden funcionar bastante bien incluso cuando las defensas cambian, afirma.

Hendrycks lanzó una primera versión del conjunto de datos, con alrededor de 6.000 imágenes, durante una reciente conferencia internacional sobre aprendizaje automático. Su plan es lanzar una versión final con cerca de 8.000 imágenes. Le gustaría que la comunidad de investigación utilice su conjunto de datos como punto de referencia.

En otras palabras, en lugar de entrenar a una IA directamente con las imágenes, estas deberían reservarse para la fase de pruebas. "Si la gente solo entrenara sus sistemas con este conjunto de datos solo estaría memorizando estos ejemplos. Eso permitiría resolver el conjunto de datos, pero no la tarea de seguir funcionando con nuevos ejemplos", afirma el investigador.

Descubrir la lógica responsable de los fallos, a veces desconcertantes, que causan esos ejemplos podría dar lugar a sistemas más resistentes. "¿Cómo es posible confundir a una libélula con el guacamole?" bromea Hendrycks, y añade: "No está muy claro de dónde surge el error".