Un análisis del proceso de creación de varios sistemas de procesamiento del lenguaje natural revela que el aprendizaje profundo genera una terrible huella de carbono. Además del problema medioambiental, este enorme coste energético limita a los investigadores públicos sin acceso a tantos recursos

La industria de la inteligencia artificial (IA) se suele comparar con la del petróleo: al igual que el combustible fósil, cuando los datos se extraen y refinan se convierten en un producto muy lucrativo. Ahora parece que la metáfora puede extenderse aún más. Al igual que el petróleo, el aprendizaje profundo tiene un enorme impacto ambiental.

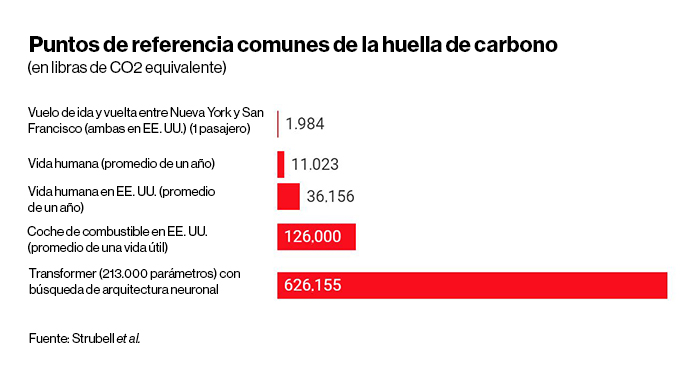

Un nuevo estudio de la Universidad de Massachusetts en Amherst (EE. UU.) ha evaluado el ciclo de vida para entrenar a varios modelos grandes y comunes de IA. El equipo ha descubierto que el proceso puede llegar a emitir casi 284.000 kilogramos de dióxido de carbono equivalente (CO2e). Este nivel de emisiones es casi cinco veces mayor que las que hace un coche estadounidense medio durante toda su vida útil (incluida la propia fabricación del vehículo).Algunos investigadores de IA ya llevaban tiempo sospechando que su tecnología no era demasiado respetuosa con el medio ambiente. El informático de la Universidad de A Coruña (España) Carlos Gómez-Rodríguez, que no participó en esta investigación, confirma: "Aunque probablemente muchos de nosotros hemos pensado en esto a un nivel abstracto y vago, las cifras realmente muestran la magnitud del problema. Ni yo ni ningún otro investigador con el que he hablado sobre esto pensábamos que el impacto ambiental fuera tan importante".

La huella de carbono del PLN

El estudio se ha centrado en el proceso de entrenar un modelo para el procesamiento del lenguaje natural (PLN), el subcampo de IA especializado en enseñar a las máquinas a manejar el lenguaje humano. En los últimos dos años, la comunidad de PLN ha logrado varios hitos extraordinarios de rendimiento en la traducción automática, la finalización de frases y otras tareas estándar de evaluación comparativa. El infame modelo GPT-2 de OpenAI, por ejemplo, destacó por escribir artículos convincentes sobre noticias falsas.

Pero para lograr tales hazañas han hecho falta modelos cada vez mayores entrenados con inmensos conjuntos de datos de frases extraídas de internet. Se trata de un enfoque computacionalmente costoso y que consume mucha energía.

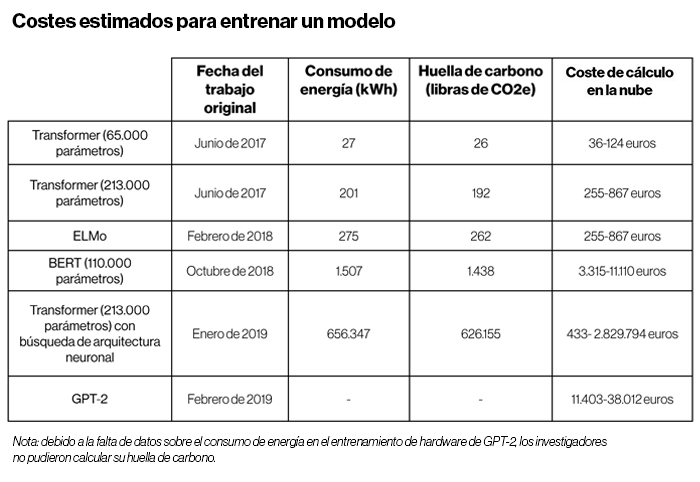

Los investigadores analizaron los cuatro modelos de PLN con mayores avances en el rendimiento: Transformer, ELMo, BERT y GPT-2. Entrenaron a cada uno en una sola unidad de procesamiento gráfico (GPU, por sus siglas en inglés) durante un día para medir su consumo de energía. Luego, utilizaron la cantidad de horas de entrenamiento registradas en los documentos originales del modelo para calcular la energía total consumida durante todo el proceso de entrenamiento. Ese número se convirtió en libras de dióxido de carbono equivalente basadas en el promedio de la combinación de energía en EE. UU., que coincide mucho con la combinación de energía utilizada por Amazon Web Services, el mayor proveedor de servicios en la nube.

Fuente: Strubell et al.

Los investigadores descubrieron que los costes computacionales y ambientales del entrenamiento aumentaron proporcionalmente con el tamaño del modelo. Y cuando incorporaron los pasos de ajuste para aumentar la precisión final del modelo, las cifras saltaron por los aires. Los resultados sugieren que un proceso de ajuste conocido como búsqueda de arquitectura neuronal (que intenta optimizar un modelo mediante el ajuste gradual del diseño de una red neuronal a través de pruebas y errores exhaustivos) tiene unos costes extraordinariamente altos para el poco beneficio de rendimiento que aporta. Además, el modelo más costoso, BERT, deja una huella de carbono de aproximadamente 1.400 libras (635 kg) de dióxido de carbono equivalente, una cifra similar a la emitida en un vuelo de ida y vuelta de una persona de extremo a extremo de EE. UU.

Los investigadores señalan que estos números solo deben considerarse como una base. "Entrenar a un solo modelo es la mínima cantidad de trabajo que se puede hacer", explica la candidata a doctorado del centro y la autora principal del artículo, Emma Strubell. En la práctica, es mucho más probable que los investigadores de IA creen un nuevo modelo desde cero o adapten un modelo existente a un nuevo conjunto de datos, ya que cualquiera de ellos puede requerir muchas más rondas de entrenamiento y ajuste.

Para tener una mejor idea de cómo se vería el desarrollo completo en términos de huella de carbono, Strubell y sus colegas utilizaron un modelo producido en un trabajo anterior como estudio de caso. Descubrieron que el proceso de construir y probar un modelo final requiere el entrenamiento de 4.789 modelos durante un período de seis meses. Cuando esto se convierte en CO2e, las emisiones ascienden a más de 78.000 libras (más de 35.380 kg). Lamentablemente, este ejemplo puede que sea el que mejor representa el trabajo de los investigadores de PLN.

La importancia de esas cifras es colosal, especialmente si se tienen en cuenta las tendencias actuales en la investigación de la IA. "En general, gran parte de las investigaciones más recientes en IA descuidan la eficiencia. Y dado que las redes neuronales muy grandes resultan útiles para una gran variedad de tareas, las empresas e instituciones que tienen un gran acceso a recursos computacionales se aprovechan de eso para obtener una ventaja competitiva. Las investigaciones de este tipo son necesarias para que la gente sea consciente de los recursos que se están gastando [...] y provocará un debate", detalla Gómez-Rodríguez.

Por su parte, el investigador postdoctoral en la Universidad de Stanford (EE. UU.) Siva Reddy, que no participó en la investigación, afirma: "Probablemente muchos de nosotros no comprendíamos la magnitud del problema hasta que vimos estas comparaciones".

La privatización de la IA

Los resultados también resaltan otro creciente problema de la IA: la gran intensidad de recursos necesarios para producir este tipo de resultados dificulta cada vez más el trabajo al mundo académico, lo que limita su capacidad de contribuir a los avances de la inteligencia artificial.

Strubell cuenta: "La tendencia de entrenar grandes modelos con toneladas de datos no es factible para los investigadores universitarios, especialmente para estudiantes de postgrado, porque no tenemos los recursos computacionales necesarios. Así que hay un problema de igualdad de acceso entre los investigadores en el mundo académico frente a los investigadores en la industria".

Strubell y sus coautores esperan que sus colegas presten atención a sus hallazgos y ayuden a nivelar el campo de juego invirtiendo en el desarrollo de hardware y algoritmos más eficientes. Reddy está de acuerdo, y concluye: "Los cerebros humanos pueden hacer cosas increíbles con muy poca energía. La cuestión más importante es cómo podemos crear ese tipo de máquinas".