Las falsificaciones automáticas de vídeo creadas mediante IA no suelen pestañear, un fenómeno que las hace más fáciles de identificar para luchar contra casos de porno vengativo y bulos. Este puede ser el comienzo de una carrera armamentista entre detectives y falsificadores digitales

El mundo ya dispone de las primeras herramientas para perseguir los casos de porno vengativo y bulos creados con inteligencia artificial (IA). Y todo gracias a un programa administrado por el Departamento de Defensa de Estados Unidos.

Más allá de los maravillosos usos del aprendizaje automático, hay quien se ha dedicado a usar la tecnología para crear vídeos falsos increíblemente realistas de forma automática que podrían utilizarse para sembrar la desinformación o acosar a las personas. Por suerte, a los expertos no les ha costado demasiado encontrar estrategias para detectarlos.

Los clips manipulados, conocidos como "deepfakes" (o falsificaciones automáticas), son fáciles de hacer y pueden ser sorprendentemente realistas. Y si un editor de vídeo participa en el proceso, puede hacer parezcan aún más reales.

Para conseguir estas falsificaciones se utiliza una técnica de aprendizaje automático conocida como redes generativas antagónicas (o GAN, una de nuestras 10 Tecnologías Emergentes de 2018). Gracias ella, un ordenador utiliza datos reales antes para aprender a producir versiones falsas estadísticamente similares (ver El señor de las GAN: el hombre que dio imaginación a las máquinas).

Las herramientas para capturar deepfakes se desarrollaron a través de Media Forensics, un programa de la Agencia de Proyectos de Investigación Avanzados de la Defensa de EE. UU. (DARPA), creado para automatizar las herramientas forenses existentes. En los últimos años, la iniciativa no ha podido evitar sumarse a la tendencia de las falsificaciones creadas mediante IA.

El director del programa Media Forensics, Matthew Turek, explica: "Hemos descubierto pistas sutiles en las imágenes y vídeos actuales manipulados por las GAN que nos permiten detectar la presencia de alteraciones".

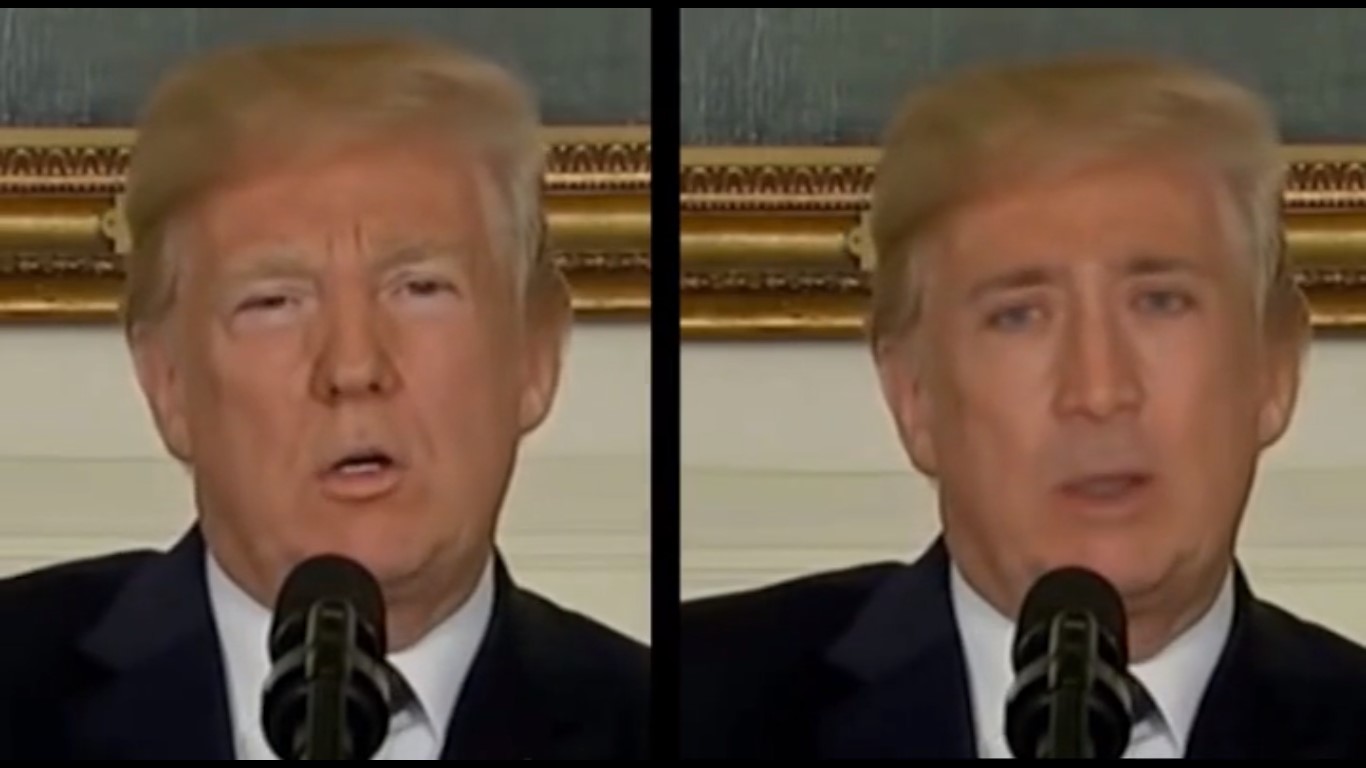

Foto: El comentarista político Tucker Carlson tiene su propio 'deepfake' que le convierte en el actor Nicolas Cage. Crédito: Universidad en Albany.

La técnica de detección, que resulta increíblemente simple, ha sido desarrollada por un equipo dirigido por el profesor de la Universidad de Albany de la Universidad Estatal de Nueva York (SUNY en EE. UU.) Siwei Lyu y uno de sus estudiantes. El responsable afirma: "Generamos unos 50 vídeos falsos y probamos varios métodos tradicionales, pero ninguno funcionó del todo bien".

Entonces, una tarde, mientras estudiaba varias falsificaciones automáticas, Lyu se dio cuenta de que las caras creadas mediante deepfakes nunca o casi nunca parpadeaban. Y cuando lo hacen, el movimiento no resulta natural. Esto se debe a que los deepfakes se entrenan en imágenes fijas, que tienden a mostrar a una persona con los ojos abiertos.

Vídeo: Un 'deepfake' de la cara de Nicolas Cage sobre la de Donald Trump. Los ojos, que no parpadean, delatan el engaño.

Otras personas involucradas en el desafío DARPA están explorando trucos similares para atrapar automáticamente las falsificaciones automáticas: movimientos extraños de cabeza, color de ojos extraño, etcétera. El experto en análisis forense digital de la Universidad de Dartmouth (EE. UU.) Hany Farid, detalla: "Estamos explorando este tipo de señales fisiológicas que, al menos por ahora, son difíciles de imitar para las falsificaciones automáticas". Por su parte, Turek afirma que la agencia realizará más concursos "para garantizar que las tecnologías en desarrollo puedan detectar las últimas técnicas".

La llegada de estas herramientas puede indicar el comienzo de una carrera armamentista impulsada por la IA entre los falsificadores de vídeo y los detectives digitales. Farid señala que un problema clave es que los sistemas de aprendizaje automático pueden aprender a superar las herramientas forenses.

Lyu explica que un falsificador hábil podría vencer a su herramienta de parpadeo con solo recoger imágenes que muestran a una persona parpadeando. Pero agrega que su equipo ha desarrollado una técnica aún más efectiva que, de momento, prefiere mantener en secreto. El investigador concluye: "Preferiría esperar un poco. Ahora tenemos una pequeña ventaja sobre los falsificadores y queremos mantenerla".