Dactyl vivió durante un siglo virtual dentro de un simulador hasta que logró controlar la extremidad con una destreza sorprendente mediante aprendizaje reforzado. Aunque en tiempo real solo pasaron unos cuantos días, el enfoque no está listo para satisfacer las demandas de la fabricación robótica

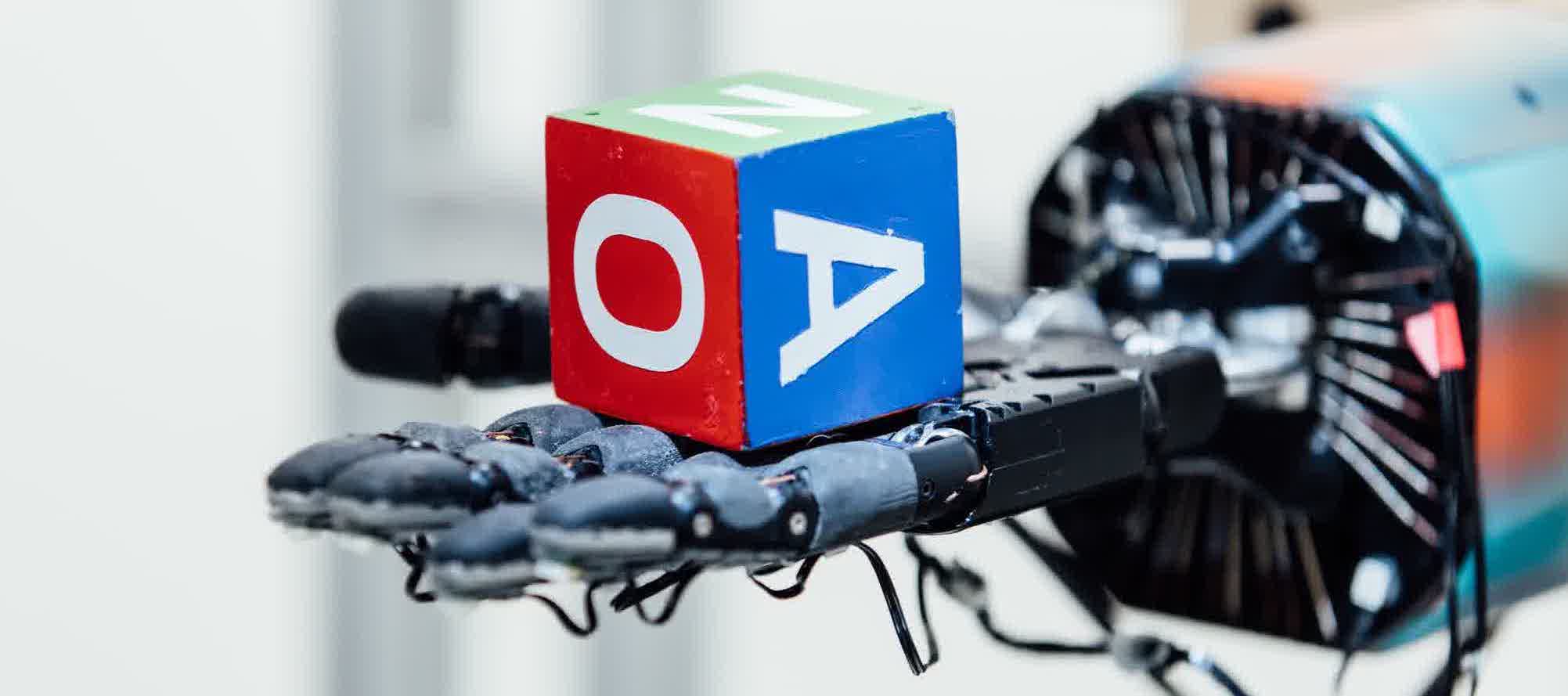

Un equipo de investigadores de inteligencia artificial (IA) acaba de presentar un algoritmo de que se ha autoenseñado a controlar una mano robótica con una destreza sorprendente. El programa se enseñó a sí mismo a manipular un cubo con una habilidad extraordinaria. Para ello practicó los movimientos durante un tiempo equivalente a 100 años en una simulación por ordenador. En el mundo real, este periodo solo duró unos pocos días.

La mano robótica aún no es tan ágil como una humana y es demasiado torpe para trabajar en una fábrica o en un almacén. Pero la investigación muestra el potencial del aprendizaje automático para adquirir nuevas capacidades robóticas. También aumenta el optimismo por el aprendizaje robótico de nuevas habilidades en entornos virtuales, una tendencia cada vez más popular y que podría acelerar el proceso de programación o entrenamiento (ver El mundo en 3D de Google: una gran escuela para la inteligencia artificial global).

El sistema robótico, llamado Dactyl, es una creación de OpenAI, una organización sin ánimo de lucro de Silicon Valley (EE. UU.). El sistema utiliza una mano robótica de la compañía británica Shadow, una cámara estándar y un algoritmo prentrenado para dominar el DotA (un videojuego multijugador) mediante el mismo enfoque de autoaprendizaje (ver Un 'Equipo A' de cinco IA colaborativas nos derrota a otro videojuego).

El algoritmo utiliza una técnica de aprendizaje automático conocida como aprendizaje reforzado. Dactyl recibió la tarea de maniobrar un cubo para que mostrara una cara diferente. A través de una serie de pruebas y errores, el algoritmo fue aprendiendo qué movimientos producían los resultados deseados.

En los vídeos de demostración se ve a Dactyl rotando el cubo con una agilidad impresionante. Fue capaz de descubrir automáticamente varios tipos de agarre que los humanos usamos habitualmente. Pero la investigación también demuestra los límites de la IA: el robot solo fue capaz de manipular el cubo con éxito 13 veces de un total de 50, y para ello necesitó un siglo de entrenamiento virtual, mucho más de lo que un niño humano necesita.

Vídeo: Sistema robótico de OpenAI en acción.

"A corto plazo, el sistema no encaja en un flujo de trabajo industrial. Pero aun así está bien, es bueno investigar", explica el profesor emérito del MIT y fundador de Rethink Robotics, Rodney Brooks, cuya start-up que fabrica robots industriales más inteligentes.

El aprendizaje reforzado está inspirado en el propio proceso de aprendizaje que siguen los animales mediante retroalimentación positiva. Aunque el enfoque se propuso hace décadas, no consiguió demostrar su eficacia hasta hace unos años, gracias a las redes neuronales artificiales (ver TR10 2017: Aprendizaje reforzado). DeepMind, la filial de Alphabet, utilizó el aprendizaje reforzado para a crear AlphaGo, el ya famoso programa de ordenador que se enseñó a sí mismo a jugar Go, el complejo juego de tablero, a un nivel superior al de todos los expertos humanos.

Otros investigadores de robótica llevan tiempo probando el enfoque, pero sus esfuerzos se han chocado con la dificultad de imitar la complejidad e imprevisibilidad del mundo real. Los investigadores de OpenAI superaron este problema al introducir variaciones aleatorias en su mundo virtual, de modo que el robot podría aprender ser consciente de la presencia de molestias como la fricción, el ruido en el hardware del robot y los momentos en los que el cubo estaba parcialmente oculto a la vista.

El ingeniero responsable del proyecto, Alex Ray, señala que Dactyl podría mejorar con una mayor capacidad de procesamiento y más factores aleatorios. "No creo que este sea el límite", afirma. Y añade que, de momento, no planean comercializar la tecnología. Su equipo se centra exclusivamente en desarrollar los enfoques de aprendizaje generalizado más potentes posibles.

"Es difícil hacerlo bien", indica el especialista en robótica de la Universidad de Michigan (EE. UU.) Dmitry Berenson, especializado en la manipulación de máquinas. El experto afirma el potencial de estos nuevos enfoques no está del todo claro. En su opinión, "hay que hacer mucho esfuerzo humano para crear la red correcta para lograr una tarea específica". Y cree que el aprendizaje en entornos simulados podría resultar muy útil. Berenson concluye: "Si podemos cruzar de manera confiable la 'brecha de la realidad', el aprendizaje se volverá exponencialmente más fácil".