Computación

Un nexo extraordinario une las leyes del universo con las redes neuronales artificiales

Nadie sabe por qué estas estructuras artificiales son tan buenas a la hora de resolver problemas complejos. Ahora los físicos afirman que el secreto está enterrado en las leyes de la física

Durante los últimos años, las técnicas de aprendizaje profundo han transformado el mundo de la inteligencia artificial. Una a una, las capacidades y técnicas que los humanos creíamos que eran únicamente nuestras han empezado a caer rendidas ante unas máquinas cada vez más potentes. Las redes neuronales profundas ahora rinden mejor que los humanos en tareas como el reconocimiento de caras y de objetos. Han dominado el antiguo juego de Go y vencido a los mejores jugadores humanos.

Pero hay un problema. No hay ninguna razón matemática que explique por qué las redes dispuestas por capas rinden tan bien ante estos retos. Los matemáticos están desconcertados. A pesar del enorme éxito de las redes neuronales profundas, nadie tiene claro exactamente cómo logran este éxito.

Hoy eso cambia gracias al trabajo del investigador de la Universidad de Harvard (EEUU) Henry Lin y el del Instituto Tecnológico de Massachusetts (MIT, EEUU) Max Tegmark. Afirman que la razón por la que los matemáticos están perplejos es que la respuesta depende de la naturaleza del universo. En otras palabras, la respuesta está en el campo de la física y no en el de las matemáticas.

Primero, abordemos el problema con un ejemplo, el de clasificar una imagen en escala de grises de un megabit para determinar si muestra un gato o un perro.

Tal imagen consta de un millón de píxeles, cada uno de los cuales puede adoptar uno de 256 valores de la escala de grises. Así que en teoría, existen 2561000000 imágenes posibles, y para cada una es necesario analizar si presenta un gato o un perro. Pero las redes neuronales, con tan sólo miles o millones de parámetros, de alguna manera logran esta clasificación con facilidad.

En el lenguaje de los matemáticos, las redes neuronales funcionan al aproximar complejas funciones matemáticas a otras más sencillas. Cuando se trata de clasificar imágenes de gatos y perros, la red neuronal debe implementar una función que tome como entrada un millón de píxeles de la escala de grises y devuelva la probable distribución de lo que podría representar.

El problema es que hay varios órdenes de magnitud más de funciones matemáticas que posibles redes para aproximarlas. Y aun así, las profundas redes neuronales de alguna manera logran generar la respuesta correcta.

Ahora Lin y Tegmark afirman haber averiguado por qué. La respuesta es que el universo está gobernado por un diminuto subconjunto de todas las funciones posibles. En otras palabras, cuando las leyes de la física se representan matemáticamente, todas pueden ser descritas por funciones que tienen un increíble conjunto de propiedades sencillas.

Así que las redes neuronales profundas no necesitan aproximar todas las funciones matemáticas posibles, sino sólo un diminuto subconjunto de ellas.

Para colocar esto en perspectiva, consideremos el orden de una función polinómica, que tiene el tamaño de su máximo exponente. Así que una ecuación cuadrática como y=x2 tiene un orden de 2, la ecuación y=x24 tiene un orden de 24 y así sucesivamente.

Obviamente, el número de órdenes es infinito y aún así sólo un diminuto subconjunto de polinomios aparecen en las leyes de la física. Lin y Tegmark escriben: "Por motivos que aún no se comprenden del todo, nuestro universo puede ser descrito con precisión por polinomios hamiltonianos de orden bajo". Normalmente, los polinomios que describen las leyes de la física tienen órdenes de entre 2 y 4.

Las leyes de la física tienen otras propiedades importantes. Por ejemplo, normalmente son simétricas cuando se trata de la rotación y escalado. Al rotar un gato o un perro 360º, tendrá el mismo aspecto; al escalarlo en 10 metros o 100 metros o un kilómetro, tendrá el mismo aspecto. Eso también simplifica la tarea de aproximar el proceso de reconocimiento de un gato o un perro.

Estas propiedades implican que las redes neuronales no necesitan aproximar una infinidad de posibles funciones matemáticas sino tan sólo un diminuto subconjunto de las más sencillas.

Existe otra propiedad del universo de la que se aprovechan las redes neuronales: la jerarquía de su estructura. "Las partículas elementales forman átomos que a su vez forman moléculas, células, organismos, planetas, sistemas solares, galaxias, etcétera", detallan los investigadores. Y a menudo las estructuras más complejas son simplemente una secuencia de pasos más sencillos.

Por eso la estructura de las redes neuronales también es importante: las capas de estas redes pueden aproximar cada paso de la secuencia causal.

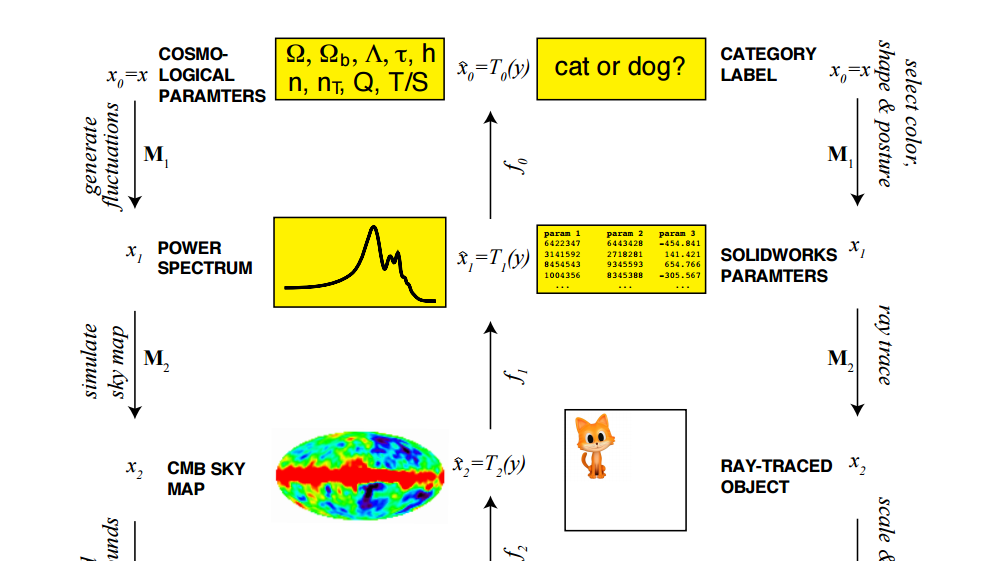

Lin y Tegmark ofrecen el ejemplo de la radiación de fondo cósmico de microondas, el eco del Big Bang que se propaga por el universo. En años recientes, varias naves espaciales han mapeado esta radiación a una resolución aún más alta. Y, por supuesto, los físicos se han extrañado por la forma que adoptan estos mapas.

Tegmark y Lin señalan que cualquiera que sea la razón, sin duda es el resultado de una jerarquía causal. "Un conjunto de parámetros cosmológicos (la densidad de la materia oscura, etcétera) determina el espectro de potencias de las fluctuaciones de densidad dentro de nuestro universo, lo que a su vez determina el patrón de la radiación de fondo cósmico de microondas que nos llega desde nuestro universo primigenio, lo que se une al ruido radioeléctrico de primer plano procedente de nuestra galaxia para generar los mapas del cielo basados en la frecuencia que son grabados por un telescopio por satélite", explican.

Cada una de estas capas causales contiene cada vez más datos. Y aunque sólo existen un puñado de parámetros cosmológicos, los mapas y el ruido que contienen están compuestos por miles de millones de números. El objetivo de la física es analizar los números grandes para que revelen los pequeños.

Y cuando un fenómeno tiene esta estructura jerárquica, las redes neuronales facilitan significativamente el proceso de analizarlo.

Los investigadores continúan: "Hemos demostrado que el éxito del aprendizaje profundo y barato depende no sólo de la matemática sino también de la física, que favorece determinadas clases de distribuciones de probabilidad excepcionalmente sencillas que solo el aprendizaje profundo está preparado para modelar".

Es un trabajo interesante e importante con serias implicaciones. Las redes neuronales artificiales se basan en la estructura de las biológicas. Así que la propuesta de Lin y Tegmark no solo explica por qué las máquinas de aprendizaje profundo funcionan tan bien; también revelan por qué los cerebros humanos pueden entender el universo. De alguna manera, la evolución ha producido una estructura cerebral que resulta ideal para desentrañar la complejidad del universo.

Este trabajo permitirá importantes progresos en la inteligencia artificial. Ahora que por fin entendemos por qué las redes neuronales profundas funcionan tan bien, los matemáticos podrán ponerse manos a la obra para explorar las propiedades matemáticas específicas que las hacen rendir tan bien. "Reforzar el entendimiento analítico del aprendizaje profundo podría ayudar a mejorarlo", apuntan Lin y Tegmark.

El aprendizaje profundo ha avanzado a pasos de gigante en los últimos años. Con este mejorado entendimiento, es probable que se acelere el ritmo de los avances.

Ref: arxiv.org/abs/1608.08225: Why Does Deep and Cheap Learning Work So Well?