Una investigación sobre las relaciones de palabras contenidas en los artículos revela que su lenguaje está claramente sesgado, y refleja los sesgos presentes en la propia sociedad

Allá por 2013, un puñado de investigadores de Google puso a una red neuronal a trabajar sobre un corpus de tres millones de palabras extraídas de textos de Google News. El objetivo de la red era buscar patrones en la manera en la que las palabras aparecen juntas dentro del texto.

Lo que encontró fue complejo, pero el equipo de Google descubrió que se pueden representar estos patrones con vectores en un espacio vectorial con unas 300 dimensiones.

Resultó que las palabras con significados similares ocupan partes similares de este espacio vectorial. Y las relaciones entre palabras pueden ser captadas con una sencilla álgebra vectorial. Por ejemplo: "hombre es para rey lo que mujer es para reina" o, lo que es lo mismo expresado según la anotación habitual: "hombre:rey :: mujer:reina". Otras relaciones emergieron pronto también como "hermana:mujer :: hermano:hombre" y así sucesivamente. Estas relaciones se conocen como "incrustaciones de palabras" o "palabras embebidas".

Este conjunto de datos se llama Word2vec y es altamente potente. Numerosos investigadores han empezado a emplearlo para mejorar el entendimiento de todo desde la traducción automática hasta las búsquedas web inteligentes.

Pero hoy el investigador de la Universidad de Boston (EEUU) Tolga Bolukbasi y varios compañeros de Microsoft Research afirman que existe un problema con esta base de datos: es claramente sexista.

Y ofrecen bastantes pruebas para respaldar esa afirmación gracias a una serie de consultas sobre el espacio vectorial para encontrar incrustaciones de palabras. Por ejemplo, es posible plantear la pregunta: "París:Francia :: Tokio:x" y el sistema proporcionará la respuesta "x = Japón". Pero, al plantearle a la base de datos "padre:médico :: madre:x" y contestará, "x = enfermera". Y la consulta "hombre:ordenador :: programador :: mujer:x" devuelve "x = ama de casa".

En otras palabras, las palabras embebidas pueden resultar increíblemente sexistas. Esto sucede porque cualquier sesgo de los artículos que componen el corpus Word2vec está inevitablemente reflejado en la geometría del espacio vectorial. El equipo de Bolukbasi se desespera con esto. "Uno podría haber esperado que las incrustaciones de Google News presentarían pocos sesgos de género porque muchos de sus autores son periodistas profesionales", escriben.

¿Qué hacer? El equipo de Boston tenía una solución. Puesto que un espacio vectorial es un objeto matemático, puede ser manipulado con herramientas matemáticas.

La solución es obvia. El sexismo puede considerarse como una especie de deformación de este espacio vectorial. De hecho, el propio sesgo de género es una característica que el equipo puede buscar dentro del espacio vectorial. Así que arreglarlo es simplemente cuestión de aplicar la deformación contraria de una manera que preserve la estructura general del espacio.

Esa es la teoría. En la práctica, lo complicado consiste en medir la naturaleza de esta deformación. El equipo lo hace al buscar parejas de palabras dentro del espacio vectorial que generarían un vector similar a "ella:él". Esto reveló una enorme lista de analogías de género. Por ejemplo: ella:él :: matrona:médico; coser:carpintería; enfermera:clínico; fulana:cobarde; peluquera:barbero; desnuda:sin camiseta; tetas:culo; nanny:chófer, y así sucesivamente.

La pregunta que querían contestar es si estas analogías son apropiadas o no. Así que emplearon Mechanical Turk de Amazon para preguntar. Mostraron cada analogía a 10 turkeros y les preguntaron si contenían un sesgo o no. Consideran que la analogía está sesgada si más de la mitad de los turkeros lo confirma.

Los resultados representan una interesante lectura. Este método revela claramente un sesgo de género en emparejamientos como matrona:médico; coser:carpintería y enfermera registrada:clínico, pero que existen pocos sesgos en emparejamientos de palabras como feminina:masculino; convento:monasterio; bolso:maletín, y así.

Habiendo compilado una amplia lista de parejas de palabras con sesgo de género, el equipo empleó estos datos para averiguar cómo se reflejan en la forma del espacio vectorial y cómo podría ser transformado el espacio para eliminar esta deformación. Denominan este proceso como la "polarización de sesgos".

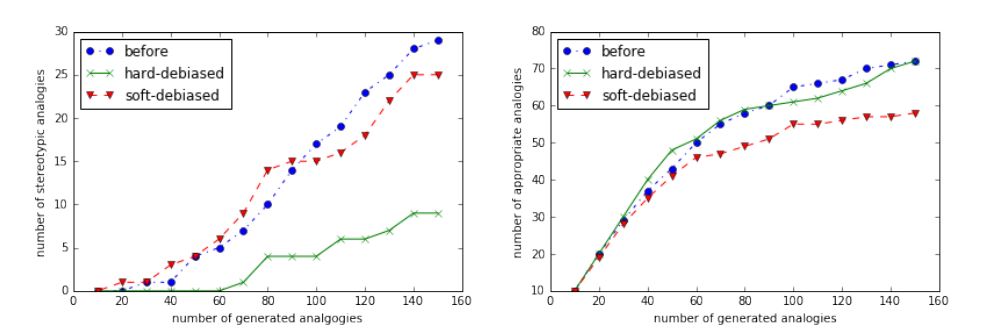

Por último, emplearon el espacio vectorial transformado para generar una nueva lista de analogías de género y después pedir a los turkeros que las calificaran de nuevo. Esto produjo nuevas parejas como ella:él::gallina:gallo; asistenta:ama de llaves; tías:chavales; hija:hijo y así sucesivamente.

Este proceso, afirman, reduce drásticamente los sesgos identificados por los turkeros. Bolukbasi afirma: "Mediante evaluaciones empíricas, demostramos que nuestro algoritmo de polarización de sesgos reduce significativamente tanto los sesgos de género directos como indirectos mientras conserva la utilidad de la incrustación".

El resultado final es un espacio vectorial en el que los sesgos de género experimentan una importante reducción.

Esto tiene importantes aplicaciones. Cualquier sesgo contenido en parejas de palabras como las de Word2vec son automáticamente transferidos a cualquier aplicación que explote ese conjunto de datos. Un ejemplo es el trabajo que emplea palabras embebidas para mejorar los resultados de las búsquedas web. Si la frase "programador informático" se asocia más estrechamente con hombres que con mujeres, entonces una búsqueda web con las palabras clave "currículum vitae de programador informático" no sólo reflejará los estereotipos sino que también podría agravar sus consecuencias", escribe el equipo de Bolukbasi.

Está claro que el lenguaje está repleto de ejemplos de sesgos de género que resultan difíciles de justificar. Una pregunta interesante es hasta qué punto este tipo de matemáticas de espacio vectorial debería ser utilizada para corregirlo.

El investigador explica: "Nuestra perspectiva sobre los sesgos de las palabras embebidas es que simplemente reflejan los sesgos presentes en la sociedad", escribe el equipo de Bolukbasi. "Sin embargo, al reducir los sesgos de los sistemas informáticos de hoy que dependen cada vez más de palabras embebidas(o al menos al no amplificar los segsos), esperamos que de alguna manera las parejas de palabras sin sesgo puedan contribuir a reducir los sesgos de género de la propia sociedad".

Parece un objetivo noble. Como concluye el equipo de Boston: "Como mínimo, el aprendizaje de máquinas no debería ser empleado para amplificar inadvertidamente estos sesgos".

Ref: arxiv.org/abs/1607.06520: Man Is to Computer Programmer as Woman is to Homemaker? Debiasing Word Embeddings.