La compañía está trabajando en un nuevo ordenador que puede cambiar los fundamentos de la computación y salvar su negocio

Dentro de la sede de Hewlett-Packard en Palo Alto, cerca de Silicon Valley (California, EEUU), hay un altar. En un extremo del edificio de investigación de HP hay dos habitaciones conectadas, amuebladas con piezas desgastadas de mediados del siglo XX que llevan décadas vacías, pero se han conservado cuidadosamente. Desde estos despachos William Hewlett y David Packard dirigieron a los ingenieros de HP en la invención de productos novedosos, como la calculadora programable que lanzaron en 1968, con un peso de 20 kilos y el tamaño de una máquina de escribir.

Ahora, en la era de los smartphones y la computación en nube, es posible que los productos básicos de HP también se queden anticuados muy pronto. Los ingresos y beneficios de la empresa han caído de forma pronunciada en los últimos años y HP está en crisis. La compañía se mantiene principalmente gracias a las ventas de servidores, impresoras y tinta (sus PC y portátiles contribuyen menos de una quinta parte a los beneficios totales). Pero, ahora que las empresas pueden recurrir a servicios en la nube gestionados por empresas como Amazon, tienen menos necesidad de adquirir servidores. Por otra parte, Amazon y las demás empresas que ofrecen estos servicios compran sus servidores a proveedores más baratos. En el otro frente, los consumidores y las empresas dependen mucho menos de las impresoras que antes y esperan pagar poco por ellas.

HP ha recortado más de 40.000 puestos de trabajo desde 2012 y este mismo año se dividirá en dos empresas más pequeñas, pero con los mismos problemas (una operación que costará en sí misma casi 2.000 millones de dólares -unos 1.860 millones de euros-). HP Inc. venderá impresoras y PC Hewlett Packard Enterprise ofrecerá servidores y servicios de tecnología de la información a las grandes empresas. Esta última dependerá en gran medida de una división cuyos ingresos anuales cayeron más de un 6% entre 2012 y 2014. Las ganancias cayeron aún más rápido hasta más de un 20%. IBM, el rival más próximo de HP, vendió su negocio de servidores a la empresa China Lenovo el año pasado al estar sometido a presiones parecidas.

A pesar de todo y en medio de esta crisis existencial, HP Enterprise trabaja en un arriesgado proyecto de investigación con la esperanza de que sea el motor de una sorprendente vuelta a la primera fila. Casi tres cuartas partes de las personas que trabajan en la división de investigación de HP se dedican a un único proyecto: un nuevo tipo de ordenador de gran potencia conocido como The Machine (La Máquina). Este ordenador redefinirá el funcionamiento de los ordenadores actuales, y los hará más sencillos y potentes. Si funciona, el proyecto daría lugar a una drástica actualización de todo, desde los servidores hasta los smartphones, además de salvar a HP.

"La gente podrá resolver problemas que no son capaces de resolver actualmente", afirma el director de tecnología de HP e instigador del proyecto, Martin Fink. The Machine daría a las empresas la posibilidad de enfrentarse a series de datos mucho mayores y mucho más complejas que las que pueden manejar ahora, explica, y hacer análisis puede que cientos de veces más rápido. Esto podría dar lugar a grandes avances en todo tipo de campos en los que el análisis de la información es muy importante. Por ejemplo la medicina genómica, donde las máquinas de secuenciación de nueva generación, mucho más rápidas, están produciendo una gran abundancia de datos. The Machine necesitará mucha menos energía para funcionar que los ordenadores existentes, explica Fink, lo que permitiría recortar las facturas de electricidad de los grandes almacenes de ordenadores que se necesitan para dar servicios de internet. El nuevo modelo de computación de HP también se podrá aplicar a aparatos más pequeños, permitiendo que portátiles y teléfonos puedan funcionar mucho más tiempo con una carga.

Sería sorprendente que cualquier empresa reinventara el diseño básico de los ordenadores, pero lo sería más aún si lo hiciera HP. Hace una década que los recortes de plantilla han estado acabando con los puestos de investigación e invierte mucho menos en I+D que la competencia: 3.400 millones de dólares en 2014 (unos 3.160 millones de euros), un 3% de sus ingresos. En comparación, IBM invirtió 5.400 millones de dólares (unos 5.020 millones de euros), un 6% de sus ingresos y tiene una tradición mucho más arraigada en llevar a cabo el tipo de investigación de base en física y computación que exigirá la creación de este nuevo tipo de ordenador. Para que el sueño de The Machine de Fink se cumpla del todo, los ingenieros de HP tienen que crear sistemas de láser que quepan dentro de chips de ordenador del tamaño de una huella dactilar, inventar un nuevo tipo de sistema operativo y perfeccionar un dispositivo electrónico para almacenar datos que nunca se ha usado aún en los ordenadores.

Sacarlo adelante sería una hazaña de la ingeniería tanto desde un punto de vista de la informática como de la empresa.

Nuevo proyecto maestro

En el año 2010 Fink dirigía la división de HP que se dedica a vender servidores empresariales de alta potencia y sentía cierta paranoia. Los clientes les abandonaban en masa para trabajar con start-ups que ofrecían almacenamiento de datos en veloces chips de memoria flash y mayor eficiencia energética como los que contienen los smartphones. HP sólo vendía la tecnología de almacenaje más lenta, pero consolidada de los discos duros. "No estábamos teniendo una respuesta lo suficientemente agresiva", afirma Fink. "Me frustraba que no tuviésemos una visión de futuro más lejano".

Intentando imaginar el futuro se preguntó: ¿Por qué no usar nuevas formas de memoria no sólo para mejorar el almacenamiento de datos, sino para reinventar los ordenadores por completo? Fink sabía que había investigadores de HP y de otras empresas trabajando en nuevas tecnologías de memoria que prometían ser mucho más rápidas que los chips flash. Él y su asesor técnico jefe crearon un proyecto maestro para usar esas tecnologías para que los ordenadores fueran mucho más potentes además de mucho más eficientes en términos de consumo de energía.

Un documento interno con esa idea, que llevaba el muy corporativo título de "Convergencia Suelta" no llegó a ninguna parte. Pero cuando nombraron a Fink director científico de HP y director de HP Labs dos años después, vio la posibilidad de resucitar su propuesta. "Cuando me paré a mirar a todos los equipos dentro de Labs pude ver que las piezas estaban ahí", afirma. En concreto, HP estaba trabajando en un producto que fuera la competencia de flash, basado en un dispositivo llamado memristor. Aunque el memristor aún estaba en fase de desarrollo, a Fink le parecía que algún día podría llegar a ser lo suficientemente rápido como para almacenar una densidad de datos suficiente como para poder poner en práctica su proyecto. Actualizó su propuesta y dio al ordenador un nombre que creía que sería temporal: The Machine. El nombre se quedó.

The Machine es un intento de poner al día el diseño que ha definido las tripas de los ordenadores desde la década de 1970. En esencia, los ordenadores se dedican a trasladar datos constantemente entre distintas piezas de hardware que contienen la información. Una, que se conoce como almacenaje, guarda tus fotos y documentos además del sistema operativo del ordenador. Consiste en discos duros o chips de memoria flash capaces de almacenar muchos datos en un pequeño espacio y guardarlos sin necesidad de una corriente (es lo que los ingenieros denominan memoria no volátil). Pero tanto los discos duros como las memorias flash leen y escriben los datos muy lentamente en comparación con el ritmo al que el procesador del ordenador puede trabajar sobre ellos. Cuando un ordenador necesita hacer algo, tiene que copiar los datos en la memoria a corto plazo, que usa una tecnología que es diez mil veces más rápida: DRAM (memoria dinámica de acceso aleatorio). Este tipo de memoria no es capaz de almacenar demasiada densidad de datos y se queda en blanco cuando no está conectada a una fuente de energía.

Este sistema de almacenamiento y memoria en dos capas significa que los ordenadores invierten mucho tiempo y energía en mover datos de un lado a otro simplemente para poder utilizarlos. Por eso tu ordenador no arranca instantáneamente: hay que recuperar el sistema operativo del almacén para cargarlo en la memoria. Una de las constricciones para la duración de la batería de tu smartphone es que necesita consumir energía para mantener los datos vivos en la DRAM incluso cuando está quieto en tu bolsillo.

Esto, que para ti quizá solo suponga una ligera molestia, es un tremendo dolor de cabeza para quienes trabajan con los ordenadores que hacen los potentes cálculos numéricos que son cada vez más importantes en todo tipo de industrias, explica la profesora de la Universidad de California en San Diego (EEUU) Yuanyuan Zhou, quien investiga tecnologías de almacenamiento. "Quienes trabajan con problemas intensivos en datos, se ven limitados por la arquitectura tradicional", afirma. HP calcula que una tercera parte del código en una pieza típica de software de análisis de datos se dedica simplemente a manejar el almacenamiento y a la memoria, no a la tarea en sí. Esto no coarta sólo el rendimiento. Tener que trasferir datos entre la memoria y el almacenaje también consume un cantidad significativa de energía, que es una de las principales preocupaciones de las empresas que cuentan con colecciones importantes de servidores, explica Zhou. Empresas como Facebook dedican millones de dólares a intentar recortar las desorbitantes facturas de electricidad de sus almacenes de ordenadores.

The Machine está diseñada para superar esos problemas y desechar la distinción entre almacenamiento y memoria. Un único gran almacén de memoria basado en los memristores de HP almacenará datos y los tendrá a disposición del procesador. Combinar la memoria y el almacenamiento no es una idea novedosa, pero aún no se ha creado una tecnología de memoria no volátil lo suficientemente rápida como para que resulte práctica, explica el profesor de la Universidad de California en Berkeley (EEUU), Tsu-Jae King Liu, quien se dedica a investigar microelectrónica. Liu es además asesor de Crossbar, una start-up que trabaja en una memoria del estilo de la memristor conocida como ReRAM. Esta y un puñado de empresas más están desarrollando la tecnología como un sustituto directo de la memoria flash en los diseños de ordenador existentes. HP es la única en afirmar que sus dispositivos proponen un cambio más radical en los ordenadores.

Para que The Machine funcione tan bien como imagina Fink, HP tiene que crear chips de memoria de memristor y un nuevo tipo de sistema operativo diseñado para usar un único almacén gigante de memoria. El proyecto de Fink también incluye dos cambios respecto al diseño habitual de un ordenador. Uno es mover los datos entre los procesadores y la memoria usando pulsos de luz enviados a través de fibra óptica, una alternativa más rápida y más eficaz en términos de energía que los cables metálicos. El segundo es usar grupos de chips eficientes especializados, como los que se encuentran en los dispositivos móviles, en vez de procesadores individuales de uso general. Los procesadores de bajo consumo, producidos por empresas como Intel, se comercializan directamente. HP tiene que inventar todo lo demás.

Ocupación principal

Hace décadas que nadie construye un sistema operativo nuevo en lo fundamental. Durante más de 40 años, cada sistema operativo "nuevo" se ha construido sobre o a imitación del que lo precedía, explica el director de software de sistema para The Machine, Rich Friedrich. La investigación académica en sistemas operativos ha sido mínima porque los sistemas existentes son dominantes.

El trabajo de Friedrich y sus compañeros será clave. El software tiene que unir los componentes poco habituales de The Machine en un sistema fiable que no se parece a ningún ordenador creado hasta la fecha. El grupo también tiene que ayudar a vender ese ordenador. Si el sistema operativo no resulta atractivo a otras empresas y programadores, los méritos técnicos de The Machine serán irrelevantes. Por ese motivo HP está estudiando dos sistemas operativos nuevos distintos. Uno se basa en el sistema Linux y se lanzará este verano, junto con software para emular el hardware que necesita para ejecutarse. Linux++, que es como se conoce este sistema, no puede hacer un uso completo de la potencia de The Machine pero será compatible con la mayoría del software existente para Linux, así que los programadores lo tendrán fácil para probarlo.

A quienes les guste podrán pasar al segundo sistema operativo nuevo de HP, Carbon, que no estará terminado hasta dentro de dos años como poco. Se lanzará como un sistema de código abierto, así que cualquiera podrá inspeccionar o modificar su código y se está diseñando desde cero para desatar toda la potencia de un ordenador que no tiene división entre almacenaje y memoria. Al empezar desde cero, Friedrich afirma que este sistema operativo quitará toda la complejidad que se ha producido en otros sistemas por años de actualizaciones sobre actualizaciones que dan lugar a fallos del sistema y de la seguridad.

Las pruebas que se han hecho hasta ahora con lo más parecido que hay a una versión funcional de The Machine, una simulación ejecutada en un grupo de potentes servidores, dan una idea de lo que podrían hacer Carbon y el nuevo ordenador una vez puestos en marcha. En una de las pruebas, The Machine simulada y un ordenador convencional echaron una carrera para analizar una foto y buscar en una base de datos con 80 millones de imágenes para encontrar las cinco más parecidas. Un servidor comercial HP de alta potencia terminó la tarea en unos dos segundos. A The Machine simulada le bastaron 50 milisegundos.

Manejar este tipo de tareas decenas o cientos de veces más rápido, con el mismo consumo energético, podría ser una ventaja clave ahora que cada vez más problemas de computación implican enormes series de datos. Si secuencias tu genoma, un ordenador tarda horas en refinar los datos en crudo para producir la secuencia terminada que se puede usar para analizar tu ADN. Si The Machine acortara ese proceso para dejarlo en unos minutos, la investigación en genómica avanzaría más rápido y sería más fácil usar la secuenciación en la práctica clínica.

El director de investigación en análisis de datos en HP, Sharad Singhal, espera que se produzcan importantes mejoras en los problemas relacionados con series de datos en forma de gráfico matemático, en los que las entidades se relacionan mediante una red de conexiones, no organizados en filas y columnas. Los ejemplos incluyen las conexiones entre la gente en Facebook o entre las personas, aviones y maletas que mueve una aerolínea. Y es probable que surjan nuevas aplicaciones impensables una vez que The Machine funcione de verdad. "Técnicas que descartaríamos como poco prácticas, de repente se convierten en algo práctico", afirma Singhal. "A la gente se le ocurrirán formas de usar esta tecnología que ahora mismo ni se nos ocurren".

Para poder cumplir con este prometedor potencial es fundamental que HP perfeccione el memristor. Ese trabajo se concentra en un pequeño laboratorio, un piso por debajo de los despachos de los fundadores de HP, donde Stanley Williams logró un importante avance hace una década.

Williams se había unido a HP en 1995, después de que David Packard decidiera que la empresa debía hacer más investigación de base. Llegó para centrarse en intentar usar moléculas orgánicas para hacer repuestos más pequeños y baratos para los transistores de silicio (ver Computing After Silicon en inglés). Pasados unos años fue capaz de hacer dispositivos que tenían el comportamiento que buscaba apilando moléculas llamadas rotaxanes entre electrodos de platino. Pero el rendimiento era desquiciantemente errático. Hubo que trabajar muchos años más antes de que Williams se diera cuenta de que las moléculas eran irrelevantes y que había dado con un descubrimiento importante. El efecto interruptor provenía de una capa de titanio que se usaba como pegamento para pegar la capa de rotaxane a los electrodos. Lo que resultaba más sorprendente es que las versiones de dispositivos construidos en torno a ese material cumplían una predicción hecha en 1971 de la existencia de un dispositivo electrónico básico completamente nuevo.

Cuando el profesor de la Universidad de California en Berkeley Leon Chua predijo la existencia de este dispositivo, la ingeniería ortodoxa sostenía que todos los circuitos electrónicos debían construirse con tres elementos básicos: capacitadores, resistencias e inductores. Chua calculó que debía haber un cuarto elemento; fue él quien bautizó el memristor, o resistencia con memoria. La propiedad esencial del dispositivo es que su resistencia eléctrica, la medida de cuánto inhibe el flujo de electrones, se puede alterar aplicando un voltaje. Y que esa resistencia, una especie de memoria del voltaje del dispositivo experimentado en el pasado, se puede usar para codificar datos.

Si todo sale según el plan, Hewlett Packard Enterprise tendrá cinco años cuando la primera versión de The Machine pueda acudir a su rescate.

La última manifestación creada por HP de este componente es muy sencilla: una pila de finas láminas de dióxido de titanio con un espesor de unos nanómetros, colocada entre dos electrodos. Algunas de las capas de la pila conducen electricidad; otras son aislantes porque no cuentan con átomos de oxígeno y dan al dispositivo en su conjunto una gran resistencia eléctrica. Al aplicar la cantidad justa de voltaje, los átomos de oxígeno pasan de una capa conductora a una capa aislante para permitir un paso más fácil de la corriente.

El investigador Jean Paul Strachan lo demuestra usando su ratón para clicar un botón marcado con un "1" en su pantalla de ordenador. Eso provoca que un flujo fino de átomos de oxígeno fluya brevemente dentro de una capa de dióxido de titanio en un memristor sobre una oblea de silicio cercana. "Acabamos de crear un puente por el que pueden circular los electrones", explica Strachan. Los números sobre su pantalla indican que la resistencia eléctrica del dispositivo ha caído por un factor de mil. Cuando clica sobre el botón marcado "0", los átomos de oxígeno retroceden y la resistencia del dispositivo vuelve a subir. La resistencia se puede cambiar así en picosegundos, unas mil veces más rápido que los elementos básicos de DRAM y usando una fracción de la energía necesaria. Y lo que es más importante, la resistencia se mantiene como se ha indicado incluso después de apagar el voltaje.

Foto: Packard y Hewlett en 1964.

Foto: Packard y Hewlett en 1964.

Cuando Williams presentó el memristor en 2008, empezó lo que él define como un recorrido de montaña rusa, porque este hallazgo de investigación base pasó rápidamente a ser un proyecto de desarrollo clave para HP. "A veces la adrenalina puede ser un poco abrumadora", afirma. Su equipo se ha dedicado principalmente a los memristores desde 2008 y en 2012 HP anunció la firma de un trato con el fabricante de chips de memoria surcoreano SK Hynix para comercializar la tecnología. En aquel momento HP estaba centrado en conseguir que los memristores sustituyeran a la memoria flash en los ordenadores convencionales. Luego, en 2012, Fink puso más presión al colocar los memristores en el centro de su plano maestro para The Machine

Un negocio arriesgado

Para usar memristores, ya sea como sustitutos de la memoria flash o como la base para The Machine, habría que empaquetarlos en chips de memoria que combinen una serie densa de los dispositivos con circuitos de control de silicio convencionales. Pero esos chips no existen ahora mismo. Y no está claro cuándo HP podrá hacerse con alguno. Depende de que un fabricante de chips como SK Hynix desarrolle chips memristor fiables adaptados a su cadena de producción. Por el momento, esta empresa envía a HP obleas de silicio con memristores que se pueden probar individualmente, pero no usar en un ordenador.

Fink y Williams afirman que los primeros prototipos de chips de memoria podrían estar listos en algún momento del año que viene. (Declaraciones anteriores de Williams sugerían que la tecnología llegaría al mercado en 2013, pero tanto él como Fink afirman que estos comentarios se malinterpretaron). Un portavoz de Hynix, Heeyoung Son, no quiso comentar sobre la posibilidad de que sea factible en 2016. "No hay un calendario específico", afirmó. "Aún se tardará un tiempo en llegar".

El profesor de la Universidad de Cornell (EEUU), Edwin Kan, que trabaja en tecnología de memoria, afirma que el progreso en los memristores y dispositivos parecidos pareció estancarse cuando las empresas intentaron integrarlos en chips densos y fiables. "Parece prometedor, pero lleva demasiado tiempo pareciendo prometedor", afirma.

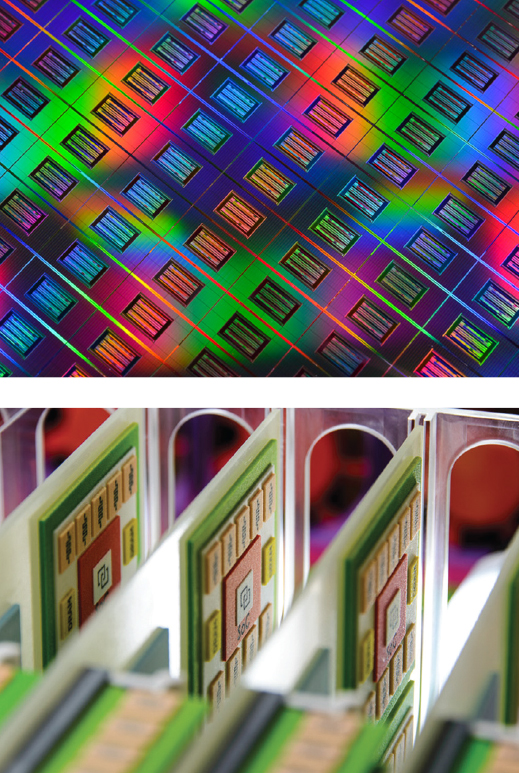

Foto: Arriba, un primer plano de memristores sobre una oblea de silicio. Abajo, detalle en un prototipo de The Machine.

Uno de los antiguos colaboradores de Williams en HP, Dmitri Strukov, afirma que los memristores aún tienen que pasar una prueba clave. Strukov, que es profesor adjunto en la Universidad de California en Santa Bárbara (EEUU) y autor principal del artículo de 2008 que anunciaba el memristor, afirma que, aunque las publicaciones técnicas presentadas por HP y SK Hynix han demostrado que los memristores individuales se pueden apagar y encender billones de veces sin fallar, no está claro aún que grandes series de memristores tengan el mismo rendimiento. "Eso es relevante", afirma.

Rodeado por prototipos de memristores en su laboratorio, Williams afirma alegremente que su confianza en la tecnología sigue siendo muy alta. "Si pensara que viene algo que es mejor, me habría lanzado a ello en un femtosegundo", sostiene. Williams tiene un gráfico en la pared que resume la competencia con un puñado de otras tecnologías de memoria que empresas, entre las que se cuentan IBM y Samsung, están colocando como posibles sustitutos de la memoria flash. Esas empresas y HP están en fases parecidas: se informa de progresos, aunque el futuro comercial de los dispositivos no está claro. Pero Williams explica que ninguna de las otras tecnologías tiene una combinación de velocidad, densidad y eficiencia energética mejor que la de los memristores. Aunque la primera generación de chips memristor aún está por llegar, su grupo ya estudia formas de que las siguientes generaciones puedan almacenar más y más datos. Estas incluyen apilar memristores en capas y almacenar más de un único bit en cada memristor.

En el laboratorio que hay en la puerta de al lado, los investigadores trabajan sobre conexiones de datos ópticas lo suficientemente compactas como para poder enlazar los componentes de un ordenador. Pero este proyecto está en una fase aún menos avanzada. Ahora mismo los ingenieros de HP pueden mostrar una oblea de silicio cubierta de diminutos láseres, cada uno con un grosor que es la cuarta parte de un pelo humano y usarlos para pulsar luz por finas fibras ópticas. Se pretende que los láseres vayan incorporados en pequeños chips que se añadan a las placas de circuitos de The Machine para conectar su memoria y sus procesadores. Los ordenadores actuales usan cables de metal para esto porque la tecnología convencional de conexión óptica abulta demasiado. Fink prevé que este sea el último de los componentes de The Machine que esté listo para usarse, hacia finales de esta década.

Cuando llegue ese momento, se podría alquilar la primera versión de The Machine a empresas o universidades que accedieran a ella a distancia para hacer análisis de datos a gran escala, según Fink. Poco después habrá servidores que siguen el patrón de The Machine a la venta. También se empezará a trabajar en reducir la escala del nuevo ordenador para usarlo en otro tipo de dispositivos, como portátiles, smartphones e incluso televisión por cable, explica.

Si todo sale según lo planeado, Hewlett Packard Enterprise tendrá cinco años cuando la primera versión de The Machine pueda acudir al rescate. Pero el mercado puede ser tan inhóspito como lo es para el negocio actual de HP.

Las nuevas tecnologías de computación tienden a ser caras y difíciles de manejar en un principio. El interés por los servidores de HP disminuye porque los servicios en nube ofrecen a las empresas justo lo contrario, una alternativa más barata y fácil de servicios que antes había que crear a medida para la compañía. Es probable que incluso las empresas que compran sus propios servidores asistan a mejoras significativas en el rendimiento durante varios años gracias a mejoras constantes en las tecnologías como el trabajo en red y el almacenaje, según el investigador sénior de Microsoft Doug Burger. "Una página en blanco es genial porque puedes redefinirlo todo, pero tienes que redefinirlo todo", afirma. "Los proyectos rompedores de éxito en sistemas de arquitectura compleja son algo muy poco frecuente".

Fink defiende que sus investigadores pueden crear herramientas que faciliten el proceso de migrar al extraño y novedoso futuro de la computación. Y cree que las empresas estarán más abiertas a aceptar una nueva plataforma cuando las mejoras incrementales en los ordenadores convencionales empiecen a producir resultados menores.

Paradójicamente, Fink también afirma que la perspectiva de no conseguir producir The Machine no le preocupa. HP puede recurrir a vender chips memristor e interconexiones fotónicas como formas de mejorar la arquitectura renqueante de los ordenadores actuales, afirma. Aunque hoy en día HP no se dedique a la fabricación de componentes. "Estamos ganando mucho haciendo esto", afirma. "No es todo o nada".

Las dificultades que atraviesa HP parecen indicar justo lo contrario.